5分钟阅读

太强了!AI直出5K大图

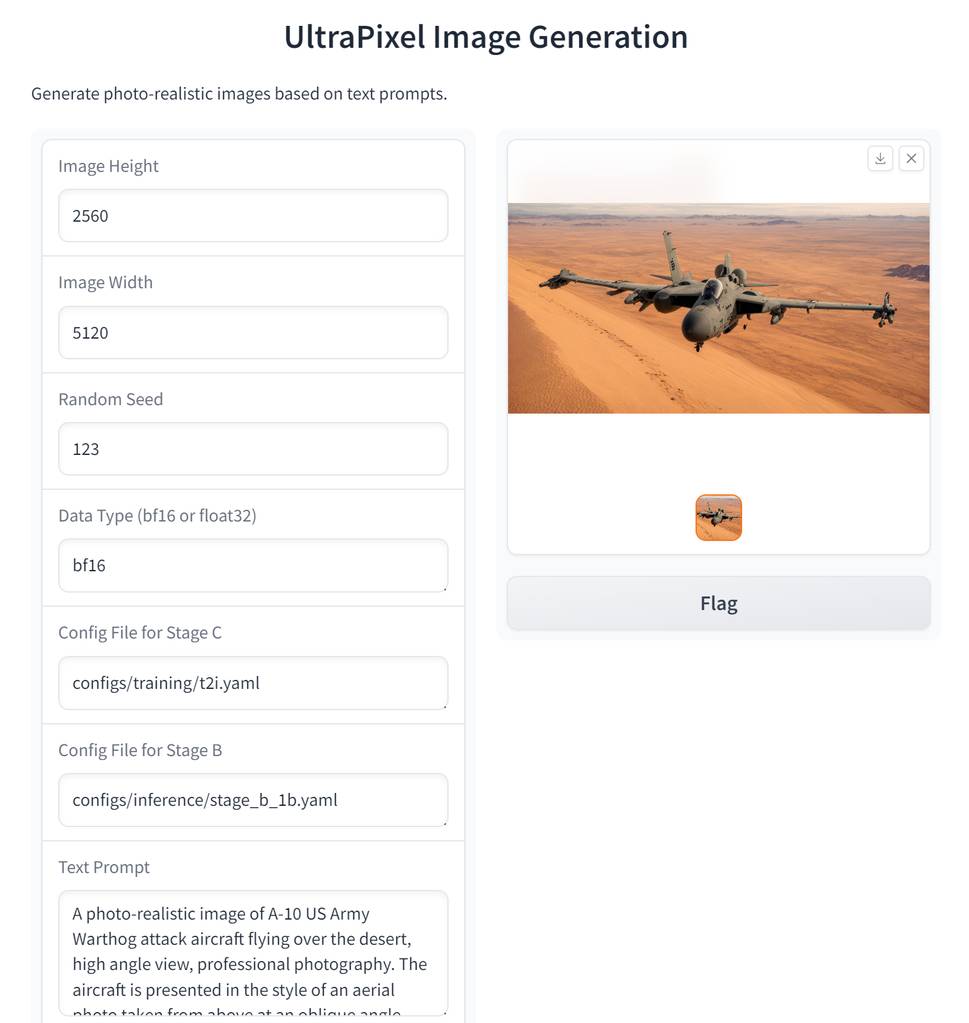

太强了!AI直出5K大图!还要什么Magnific放大呀~😂。

还记得前几天我介绍了一个直出5k大图的项目,由华为和香港科技大学(广州)联合推出的UltralPixel。

感兴趣的朋友可以回顾以下:# 【AI前沿】值得关注的几个AI消息

而就在刚刚,UltraPixel放出项目源码,可以进行体验了。

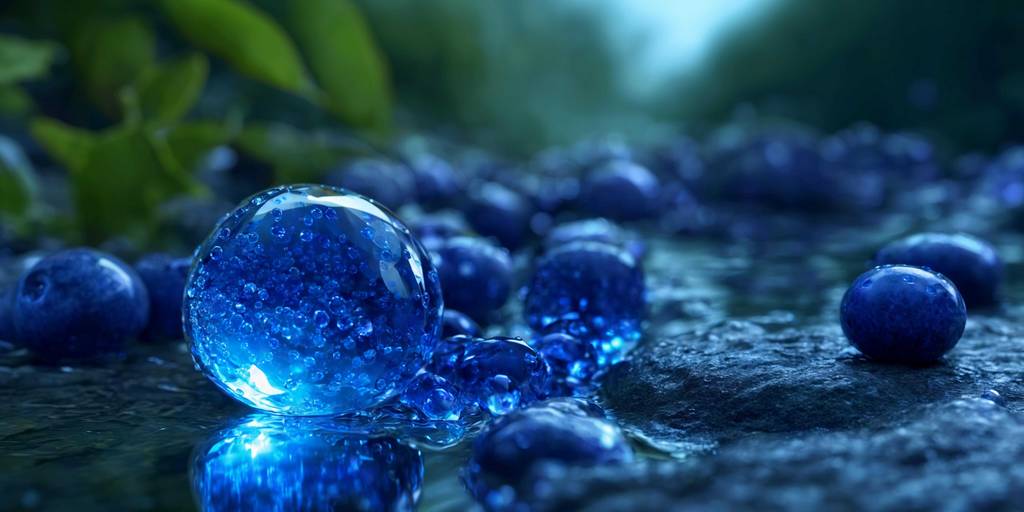

先看效果

一键直出的效果,分辨率5120x2560

细节图看看。

微信文章有压缩,实际细节很丰富。

体验教程

准备条件:

- WSL2环境。实测使用WSL2环境安装和体验过程比较流畅,windows会提示少东西。

- 官方的模型。UltraPixel 以 StableCascade 为基础,所以底模是StableCascade。

拉取源码

git clone https://github.com/catcathh/UltraPixel

安装依赖

cd UltraPixel

pip install -r requirements.txt

下载模型

下载这个文件,到项目的modles文件夹内:

https://github.com/Stability-AI/StableCascade/blob/master/models/download_models.sh

终端运行:

bash download_models.sh essential small-big bfloat16

注意是下载small-big

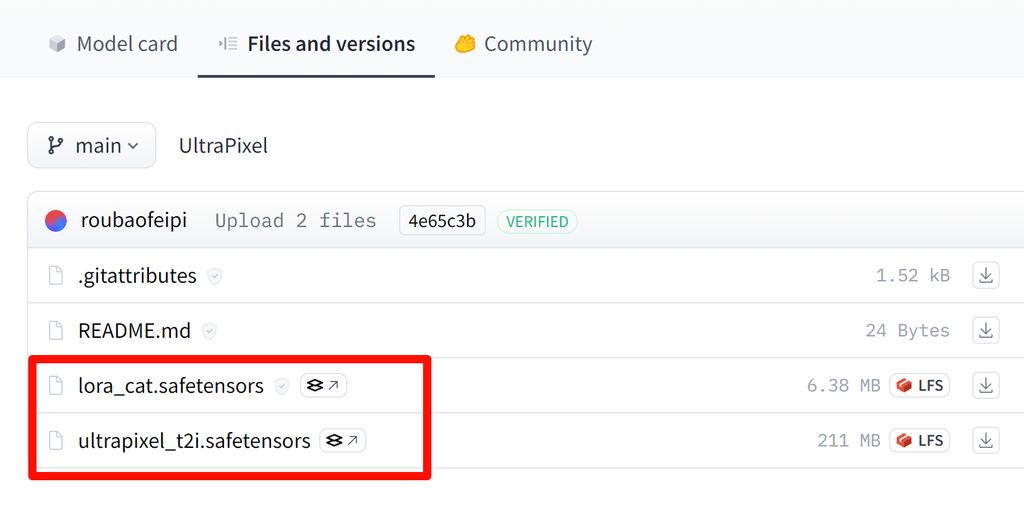

再从这里下载两个小模型:

https://huggingface.co/roubaofeipi/UltraPixel

以上模型通通放大models目录下即可。

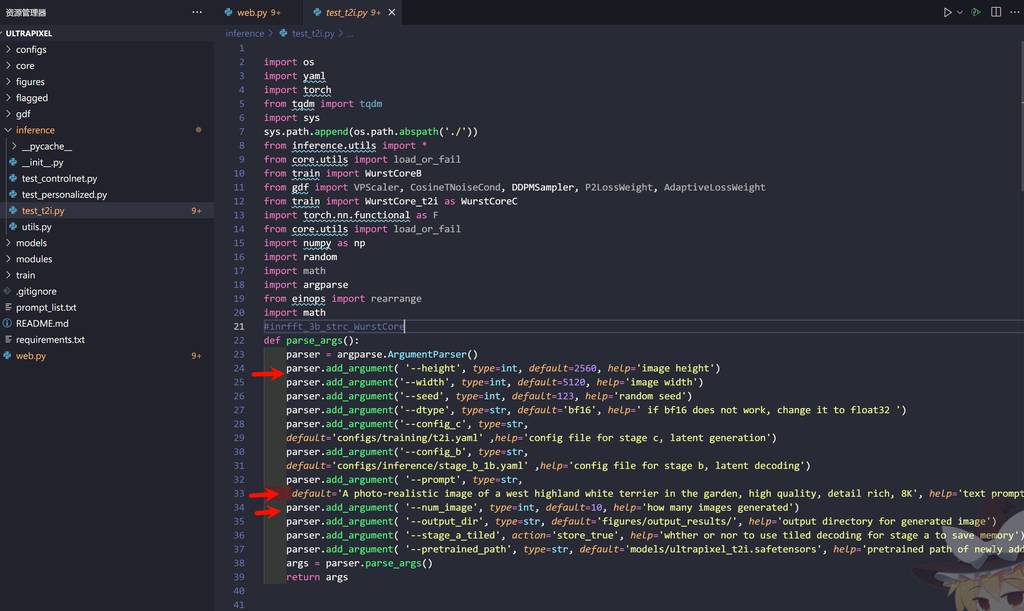

修改参数

修改inference目录下的test_t2i.py这个文件,下面的参数相信大家都能看懂,按需求更改即可。

我在源代码基础上,做了个webui的,大家也可以拉取我的代码进行体验,文末有链接。

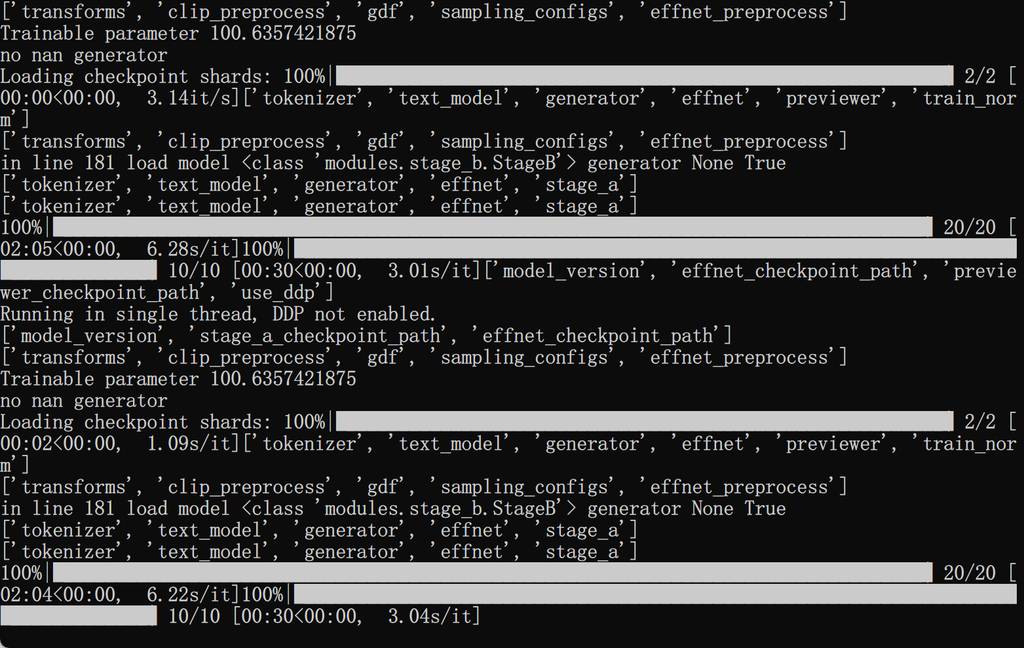

运行

运行只需要以下代码:

CUDA_VISIBLE_DEVICES=0 python inference/test_t2i.py

以上是文生图方式,作者还提供controlnet方式和personalized方式。

实测,4090生成5126x2560分辨率,单张图耗时5分钟,跟用sdxl再进行放大处理的时长差不多。

webui版本

为了方便大家体验,我基于源码,加了个gradio的webui,可以直接输出参数,进行文生图,项目地址:https://github.com/leoleelxh/UltraPixel_webui。

按照以上方法完成安装后,运行:

CUDA_VISIBLE_DEVICES=0 python web.py

好了,分享介绍就到这里,有什么疑问或者问题,可以留言交流哦~

关注我公众号(设计小站):sjxz00,获取更多AI辅助设计和设计灵感趋势。