5分钟阅读

重磅消息!Midjourney支持一致性角色

经过两周的翘首以盼,Midjourney 终于迎来了角色参考功能的支持!这意味着现在可以保持角色生成的一致性了。这个重磅消息绝对值得占据头条,相信网络上的众多AI领域博主们已经纷纷撰文详细介绍。在此,我不再赘述,直接切入正题,教大家如何上手这一新功能,并且会分享一些图片,让大家亲身体验这一新特性的魅力。

使用方法

总结来说:

- 在提示词后输入 —cref 网址,并附上一个角色图片的网址。

- 你可以使用 —cw 来调整参考“强度”从100到0。

- 强度100(—cw 100)是默认设置,会使用脸部、头发和衣服信息。

- 在强度0(—cw 0)时,它仅关注脸部(适合更换服装/头发等)。

- 你可以使用多个网址来混合多个图片的信息/角色,像这样输入 —cref 网址1 网址2(这类似于多个图像或风格提示)。

官方完整公告

这项功能与“风格参考”相似,不同之处在于,它不是匹配参考风格,而是试图让角色与“角色参考”图片相匹配。

使用方法:

- 在提示词后输入 —cref 网址,并附上一个角色图片的网址。

- 您可以使用 —cw 来调整参考的“强度”从100到0。

- 强度100(—cw 100)是默认设置,会使用脸部、头发和衣服的特征。

- 在强度0(—cw 0)时,它主要关注脸部(适合更换服装/发型等)。

适用场景:

- 此功能在使用Midjourney生成的角色图像时效果最佳。它并不适用于真实人物/照片(且可能会像普通图像提示一样扭曲它们)。

- Cref 与常规图像提示相似,但更专注于角色特征。

- 这项技术的精确度有限,它不会复制具体的酒窝/雀斑/或T恤标志。

- Cref 适用于 Niji 和普通 MJ 模型,并且可以与 —sref 结合使用。

高级特性:

您可以使用多个网址来融合来自多张图片的信息/角色,输入格式如下:—cref 网址1 网址2(这与多个图像或风格提示相似)。

在网页alpha版本中如何使用?

将图片拖拽或粘贴到想象栏中,现在有三个图标可供选择。选择这些图标可以设置图片提示为图像提示、风格参考或角色参考。使用 Shift+选择选项,可以用一张图片应用于多个类别。

请注意,尽管 MJ V6 目前处于alpha阶段,此功能和其他功能可能会突然变化,但V6官方测试版即将到来。

样图测试

为了方便测试,我拿大家熟悉的明星脸部特征,大家对比看看。

Anne Hathaway

原图

MJ出图

提示语:

girls portrait, thin lips, hair in a bun, studio light, black turtleneck, black background. --ar 9:16 --cref [https://s.mj.run/SwR3r2Tz6n0](https://s.mj.run/SwR3r2Tz6n0 "https://s.mj.run/SwR3r2Tz6n0") --s 750

提示语:

girls portrait, thin lips, blue short hair, studio light, black turtleneck, black background. --ar 9:16 --cref [https://s.mj.run/SwR3r2Tz6n0](https://s.mj.run/SwR3r2Tz6n0 "https://s.mj.run/SwR3r2Tz6n0") --cw 0 --s 50 --style raw

这次改变的发型和发色。

来个卡通效果的,效果也非常不错!

提示语:

A female person speaking look at camera, 3D cartoon, disney pixar style --ar 9:16 --cref https://s.mj.run/SwR3r2Tz6n0 --s 750 --cw 0 --niji 6

假如觉得# Anne Hathaway 的脸部轮廓过于Man了,可以加入东方的女性美,那就加上超越小姐姐中和一下吧 🤦。

超越小姐姐原图。

A female person speaking look at camera, 3D cartoon, disney pixar style --ar 9:16 --cref https://s.mj.run/SwR3r2Tz6n0 https://s.mj.run/prELVtNTwzU --s 750 --cw 0 --niji 6

看起来更符合东方的审美了!

经过简单测试,可以说,mj这次的一致性功能还是非常赞的,已经超过了SD各种换脸和换风格方法,后面又新玩法,我会继续分享给大家!

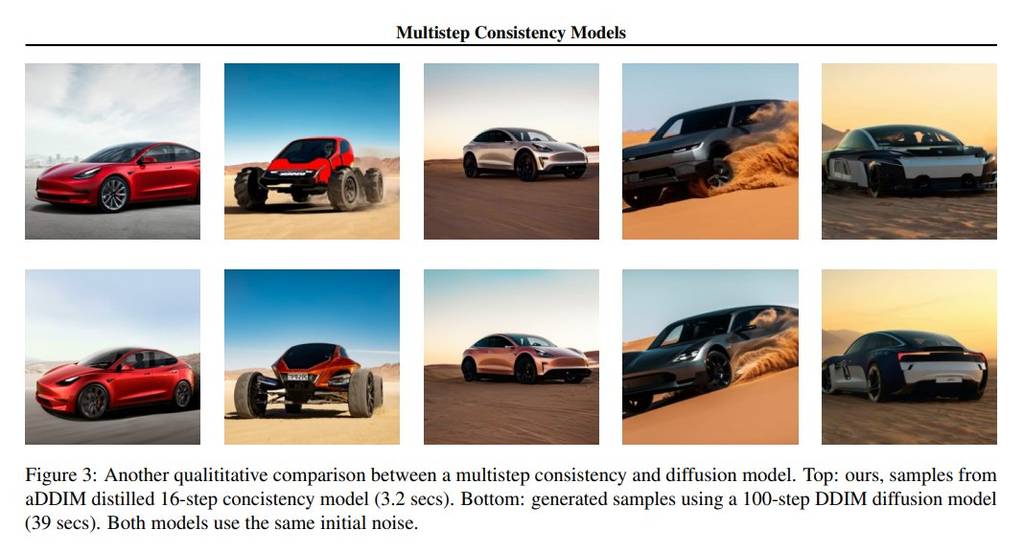

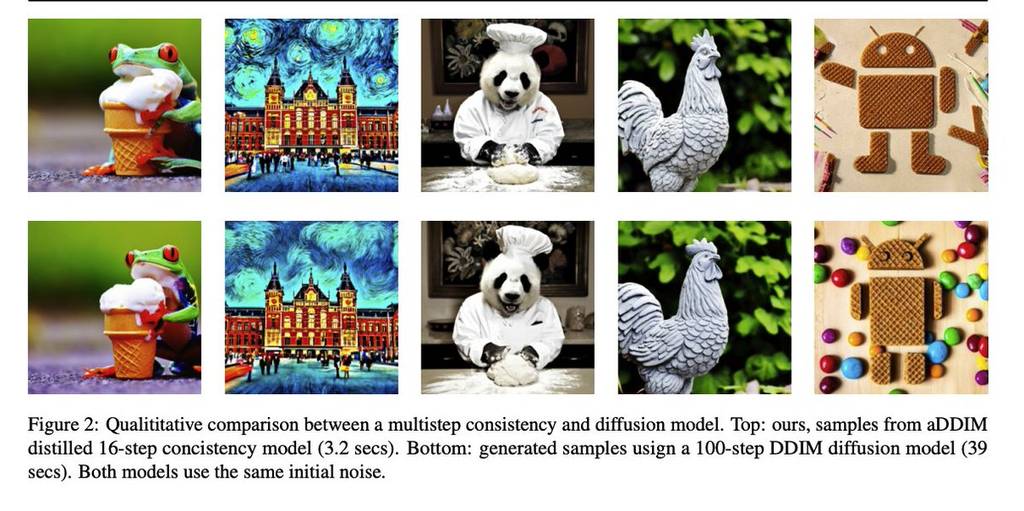

Google在一致性模型的研究

也在今天,Google也发布了Multistep Consistency Models(多步一致性模型)论文,谷歌的新研究提出了一种多步骤一致性模型,它桥接了一致性模型和扩散模型的优势,通过增加步骤数量,实现了采样速度和质量之间的优化平衡。这种模型在图像生成任务中表现出色,并在多项实验中取得了高质量的样本,具有很高的实用价值。

以下是原文:

扩散模型训练相对简单,但生成样本需要多个步骤。一致性模型训练难度较大,但能在一步内生成样本。在这篇论文中,我们提出了一种融合了一致性模型(Song等人,2023年)与TRACT(Berthelot等人,2023年)的多步骤一致性模型,能在一致性模型和扩散模型之间进行插值:在采样速度和质量之间取得平衡。具体来说,一步的一致性模型是传统的一致性模型,而我们证明,无限步的一致性模型实际上就是扩散模型。多步骤一致性模型在实际应用中表现卓越。通过将样本预算从单步增加到2-8步,我们能够更容易地训练出生成高质量样本的模型,同时保留大部分采样速度的优势。值得注意的是,在使用一致性精馏的情况下,我们在8步内达到了Imagenet 64的1.4 FID和Imagenet128的2.1 FID。此外,我们还证明了我们的方法可以扩展到文本到图像的扩散模型,生成的样本质量与原始模型非常接近。

这项研究具有深远的意义,它预示着未来AI生成内容(AIGC)将更加精准和可控。 说来有趣,谷歌似乎总是错过焦点。记得上次是Gemini Pro 1.5的发布,结果风头却被Sora抢走,这真是让人会心一笑啊 😂。不过,谷歌的这项创新无疑将引领行业迈向新的发展方向。

关注我公众号(设计小站):sjxz00,获取更多AI辅助设计和设计灵感趋势。