5分钟阅读

一图生万物,一张渲染图就够了

作为一个设计师,我总是在琢磨如何让产品在真实生活中好看又好用。以前,设计完一个产品之后,接下来就是那一套老调重弹:得一个劲地搭建模型房间,调那亮得能照见未来的灯光,再拿出各种材料来试,最后坐那儿等着电脑渲染出最后的效果,老实说,等电脑渲染的那段时间足够把人给闷出病来。

但现在,AI技术就像是我们设计师手里的瑞士刀,用它可以大大地提升我们的工作效率。有了AI,我们可以快速试验产品在不同场景的样子,而且不用等半天,几乎可以即时看到结果。这就意味着,我们可以把更多的时间用在创新设计上,而不是在等待渲染上煎熬。简而言之,AI技术让整个设计过程都变得轻松不少,让我们能更快乐地做设计,而不用担心那些花时间的繁琐流程。

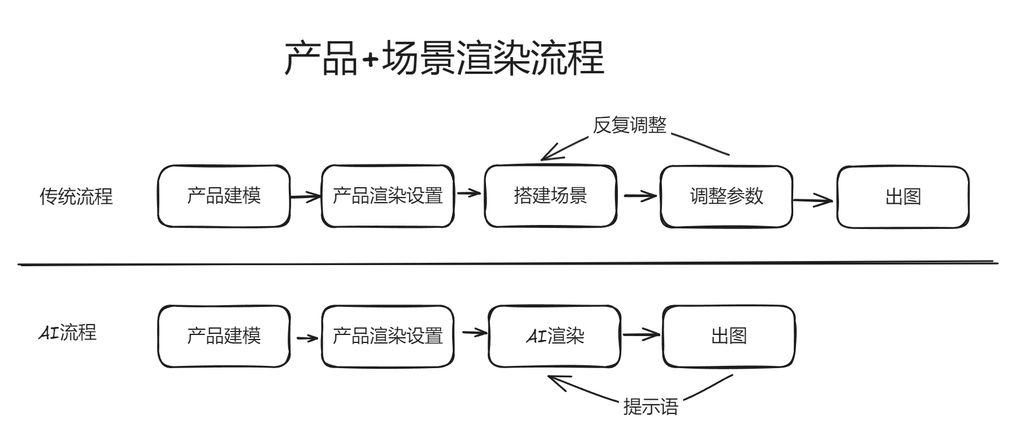

看看流程的对比

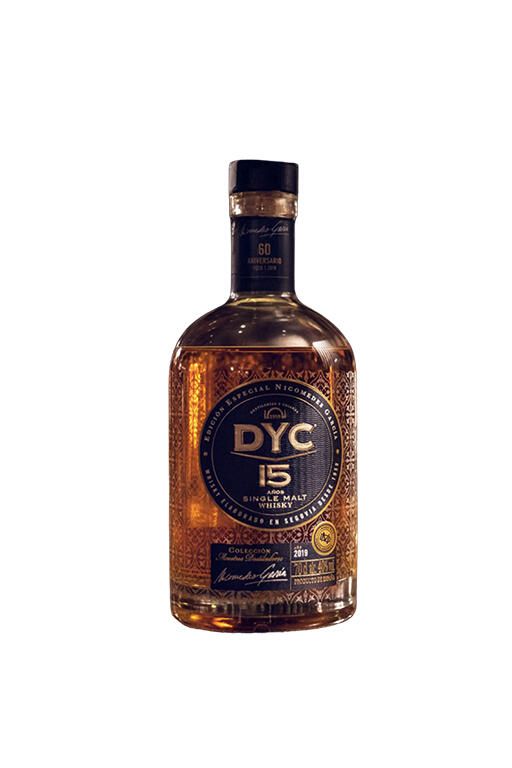

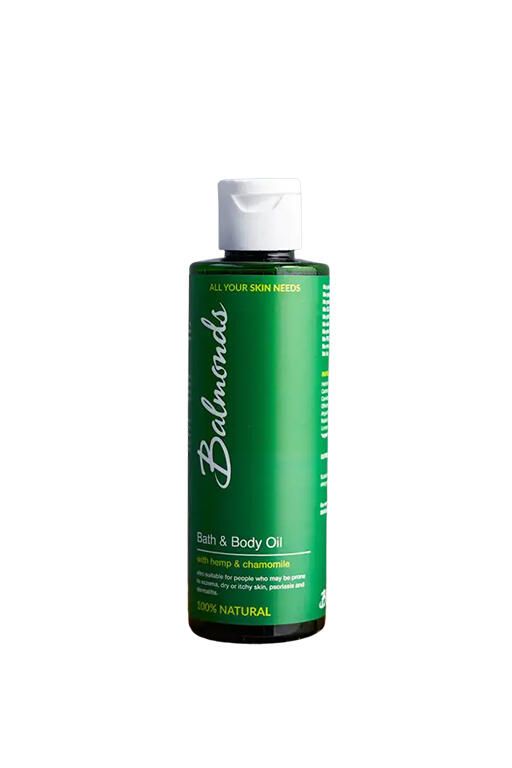

再来看看效果

以下场景图片均由AI自动生成。

上为原图,下为AI出图。

准备工作

- comfyui。自行B站看教程哈,可以回复【comfyui】我可以发给你秋叶的整合包

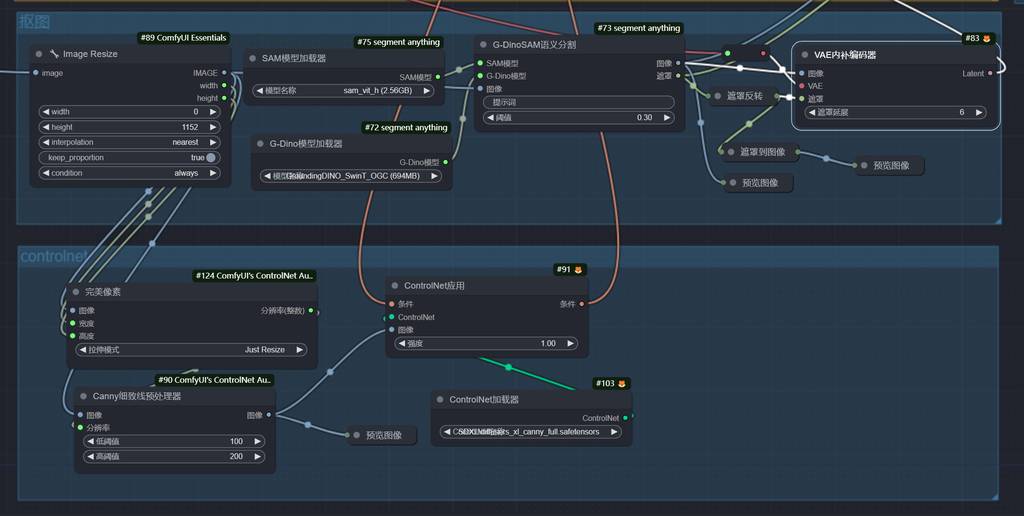

- segment anything(分割万物),使用meta公司出的AI模型。项目地址: https://github.com/storyicon/comfyui_segment_anything

思路讲解

基本思路是利用segment anything识别物体并形成蒙版,然后重绘非蒙版区域,接着进一步对图片进行重绘。

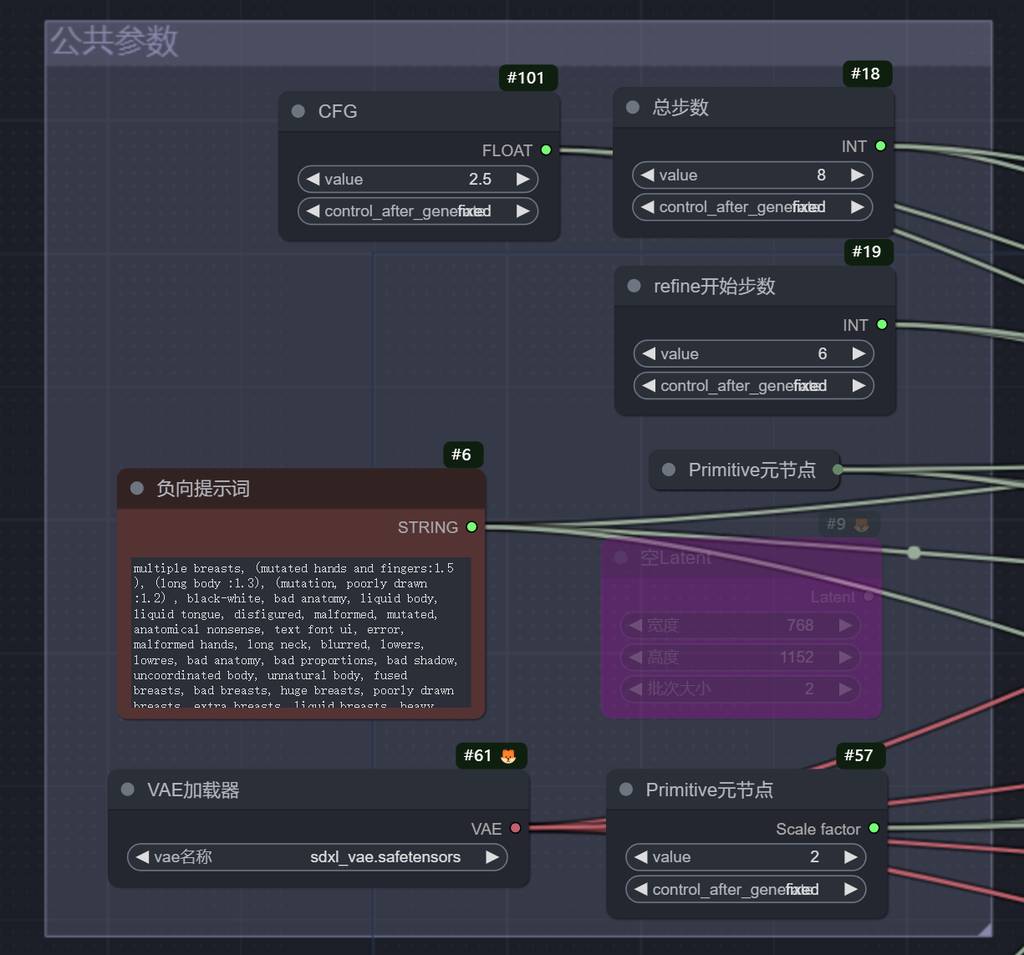

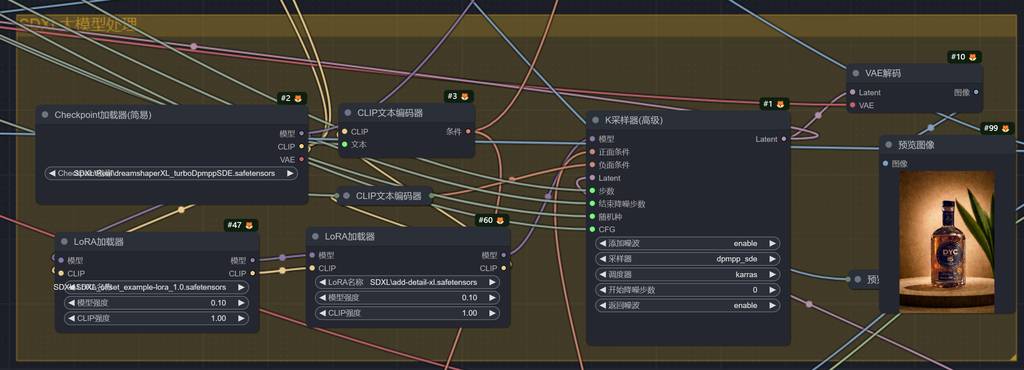

公共参数

将常用的设置抽离出来,可以快速设置。这里我用了SDXL的turbo模型,总步数可以10以内,出图更快。

第一次采样

用了dreamshaperXL模型,带turbo,真实效果。

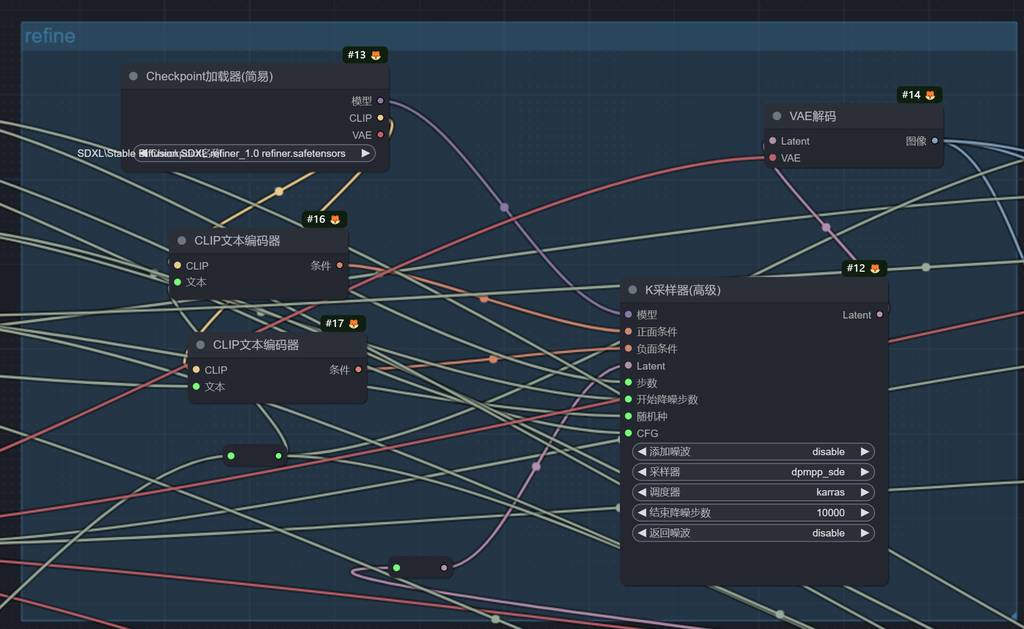

refine

refine处理,这个我在上篇推文有说过的,这里不再赘述。

抠图和cntrolnet控制

把产品抠出来,并把蒙版传递到采样器,同时增加controlnet作为图像控制,避免出现乱七八糟的东西。

叠加原图像

对于细节比较难处理,或者AI出图与原图差别很大时,可以增加叠图节点,这样就100%还原原来产品了,但是光影融合处理不会太好,大家自行斟酌对比吧。

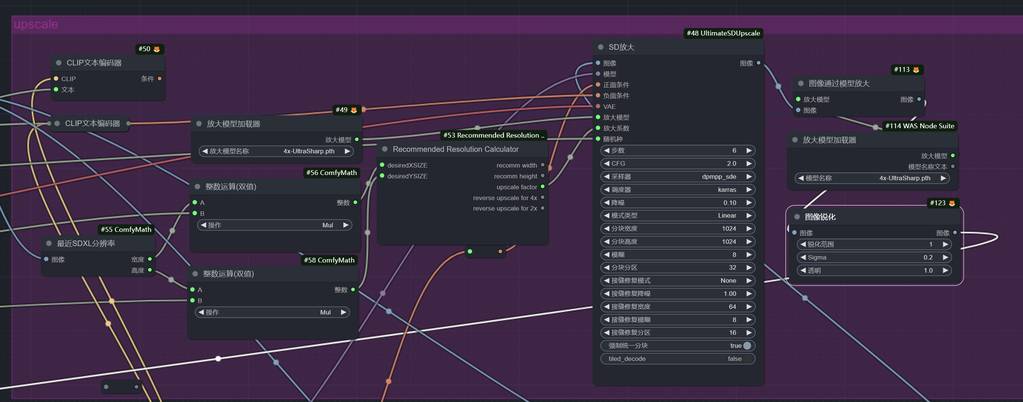

放大和后处理

通过upscale放大,并进行4x放大,最终锐化得到成品图。

总结

流程其实很简单,利用这个流程,理论上可以换各种产品的背景,后面我还会针对换特定背景,设计一个流程。大家有需求的敬请期待。

关注我,获取更多AI帮助设计的知识!!