5分钟阅读

关于LoRA训练的二三事

前言

最近我做了两期使用自己训练的 lora 去生成脚模和手模的文章,大伙的关注度还是蛮高的。也在后台纷纷私信我如何训练 lora。

自训练 lora 配合 comfyui 工作流的文章:

自训练 lora 配合 comfyui 工作流的文章:

其实,现在的训练程序已经变得非常傻瓜化了。

当然如果要深入微调,是需要对深度学习有更深入的了解。就“出效果“”而言,训练工具的默认参数下,如果素材质量不差,那么也会达到出效果这样的要求的。

之前我也记录过如何训练 sdxl 和 flux lora,主要是训练风格 lora 为主,感兴趣的可以回顾一下:

【AI辅助设计】没错!训练FLUX LoRA就这么简单! 【AI辅助设计】记一次图标风格LoRA训练

以上两篇文章,已经记录了从素材获取、素材处理(裁剪、打标)、到训练参数设置,如果大家想要理解训练的基础,可以前往去看看。

本人非深度学习专业的,对训练还是粗浅😂,如果想深入了解训练的相关的,可以在 B 站搜索相关教程哈~

所以,今天不打算再讲这个 lora 的训练过程了,只补充一些我认为值得设计师或者新手快速训练出 lora 的事。

第一事:工具的选择

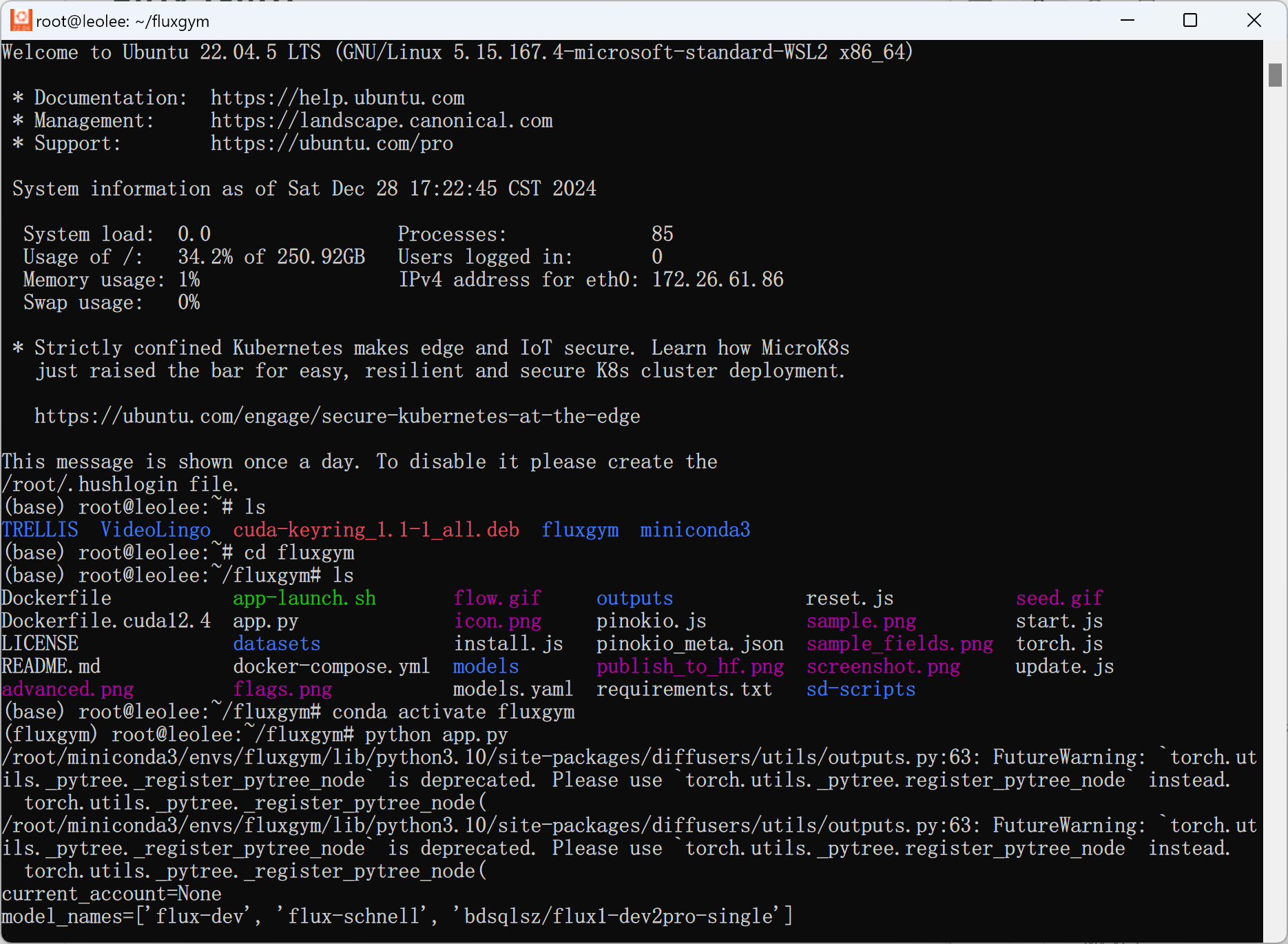

设计师有好的工具:fluxgym

如果要选一个工具,我推荐 fluxgym,主要是体验非常好,直接用默认参数出的效果也不错。

当然,这个项目也是基于:AI-Tookit、Kohya Script 这个两个训练始祖发展而来的,只是做了一些易用性和界面上的改动,使得界面对新手、设计师友好。

从界面,其实就可以看到流程是非常清晰的。只需要三步设置。尤其是第二步,内置了围绕的反推模型,可以较为精准地为素材打标,省去不少工作。

如何部署 fluxgym?

虽然,工具本身对设计师友好,但是部署上还是需要一丢丢努力💪。

性能最优方案:wsl 2 部署

深度学习离不开 linux,如果有条件大家还是基于 Windows 子系统(wsl),部署一个,这样性能上损耗最小,且易于更新。

我还是那个观点哈,AI 时代,设计师还是需要懂点代码,不需要多深入,在 gpt 等一众助手的帮助下,会搭个简单,了解技术框架,其实就够了 😎。

走远了,我们回到正题,如果确实不会、不想搞 wsl 怎么办呢?

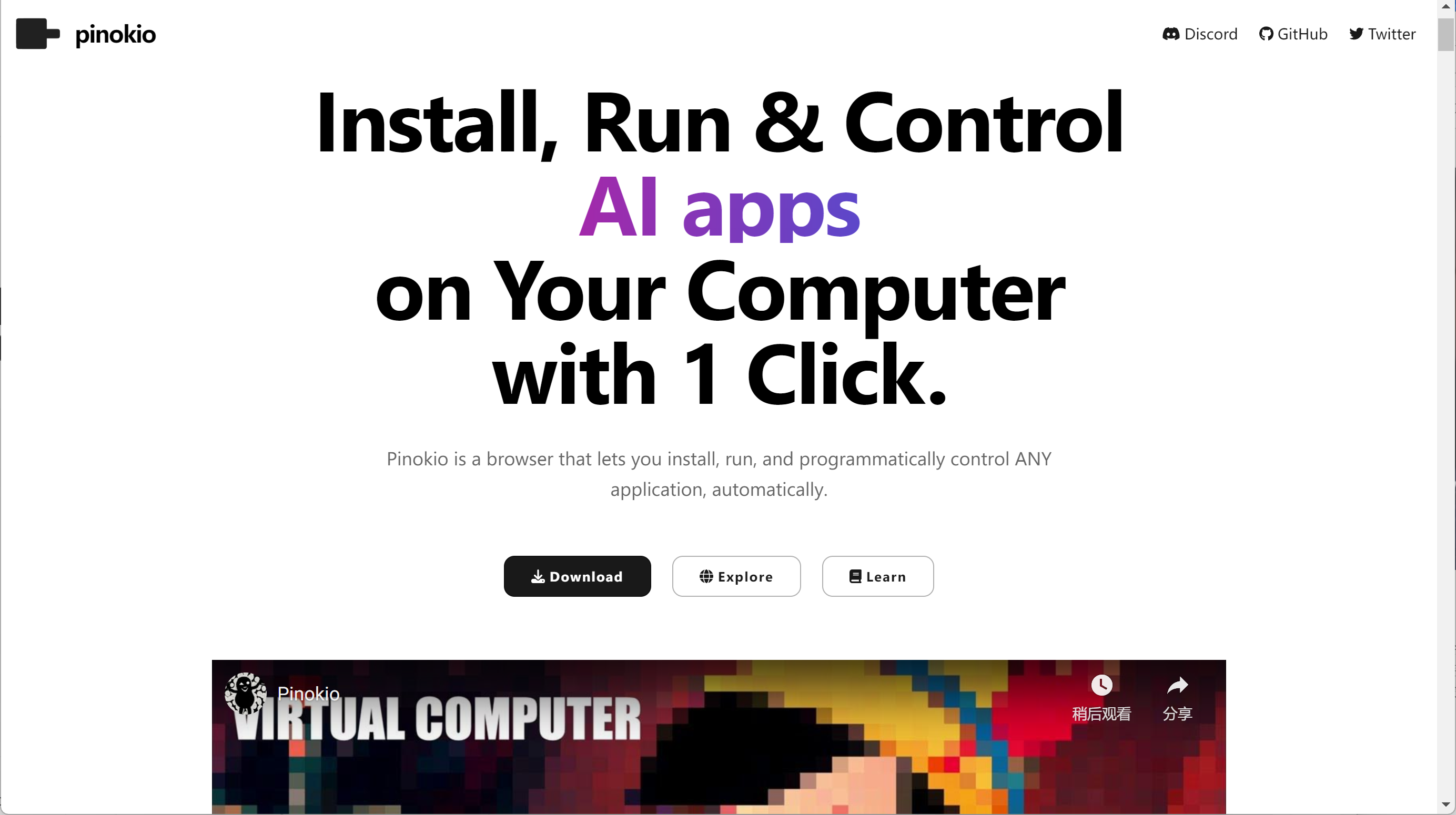

AI 时代的 docker?Pinokio

因为处理 wsl 环境的搭建,还需要安装 cuda、conda 等等,也挺难的,对于设计师而言。

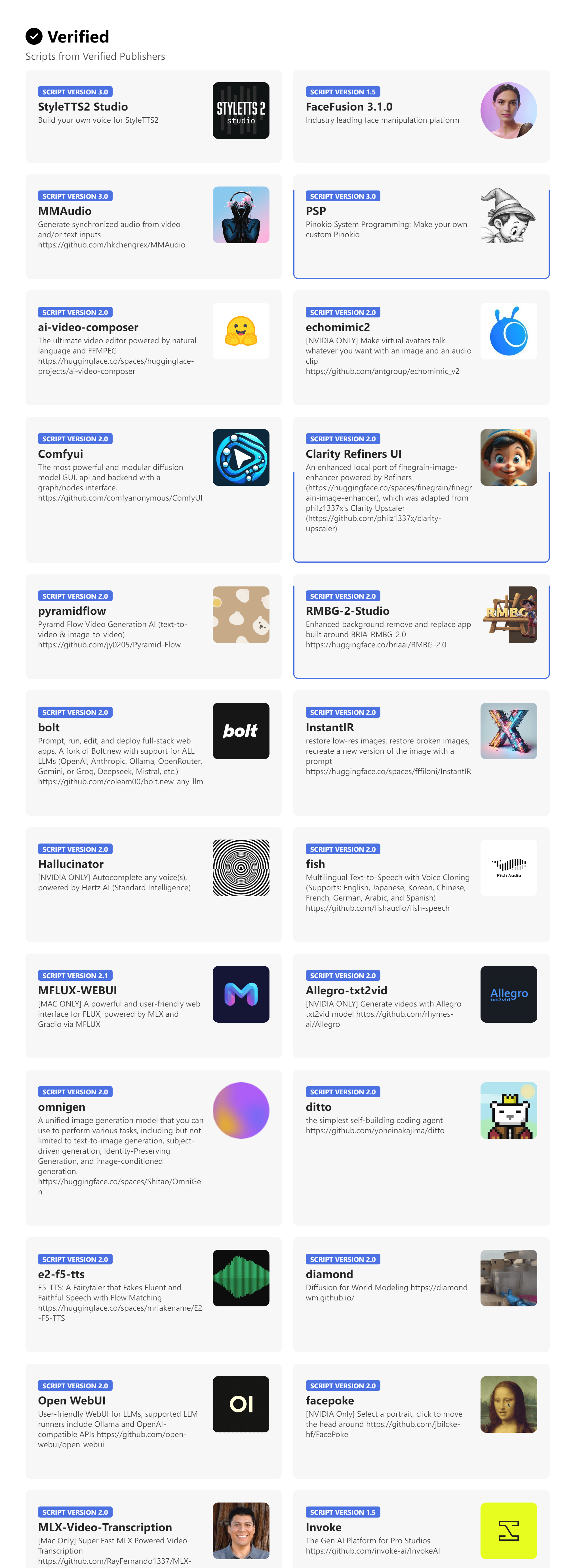

那么我推荐一个工具:Pinokio,大家可以理解为他就是一个环境或者一个容器,很多 AI 应用都可以一键部署,自动化安装依赖。

目前支持一键部署的 AI 应用还是挺多的,主流的,热门的都有。

使用非常简单,官网上找到喜欢的应用,点击一键安装即可。当然,前提是你已经安装了 pinokio 客户端。

这样,设计师们应该能用起来了吧~

第二事:大模型选择

推荐选择:Flux-dev 2 Pro

地址:https://huggingface.co/ashen0209/Flux-Dev2Pro

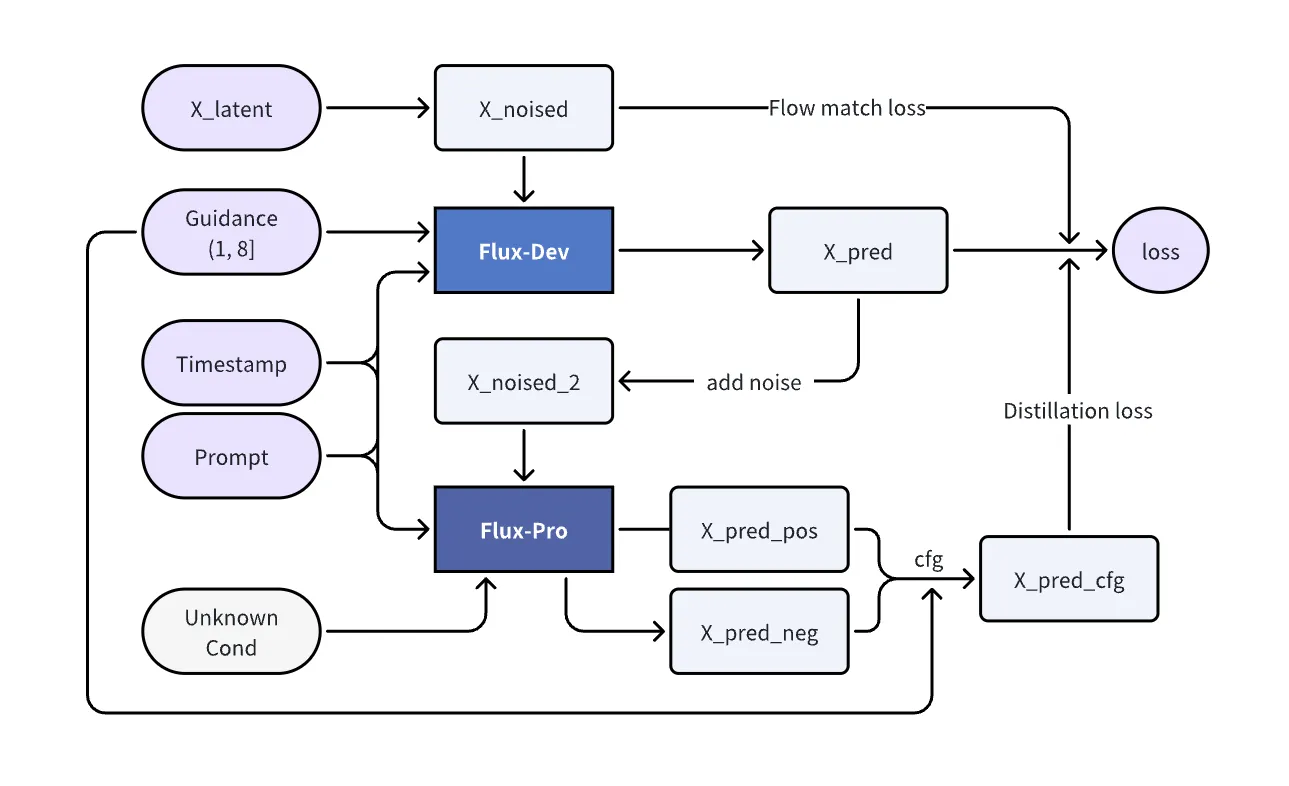

许多人第一反应,flux 底模就是使用 flux. 1 dev 版本进行训练,其实不然,虽然 flux 系列模型,在出图时,比起 sdxl 和 sd 1.5,甚至 sd 3 都有很大的进步,但就训练而言,难度却比 sd 系列要高,主要体现在要么在短时间内完全崩溃,要么产生糟糕的微调效果。人体肢体扭曲、语义理解减弱以及图像模糊无意义等问题变得普遍。

这篇文章出自:https://medium.com/@zhiwangshi28/why-flux-lora-so-hard-to-train-and-how-to-overcome-it-a0c70bc59eaf

我尝试总结一下:

Flux-dev LoRA 训练的劣势

-

引导尺度(Guidance Scale)问题

Flux-dev 在训练 LoRA 时,依赖传统无分类器引导(CFG),这需要额外的计算资源,且容易导致模型失效或图像质量下降。CFG 的复杂性使得训练过程难以稳定控制。 -

模型失效风险

在微调过程中,Flux-dev 容易出现模型失效的情况,尤其是在高引导尺度下。这导致生成的图像质量不稳定,甚至无法生成有效结果。 -

计算成本高

CFG 在训练和推理阶段都需要额外的计算资源,增加了训练成本和时间消耗。 -

蒸馏技术的局限性

Flux-dev 通过蒸馏将引导机制融入模型,但蒸馏过程可能丢失部分信息,导致模型在某些场景下表现不佳。

Flux-dev 2 Pro 的改进与效果

-

优化引导尺度设置

Flux-dev 2 Pro 在训练 LoRA 时,将引导尺度固定为 1.0,避免了传统 CFG 的复杂性。这一设置显著提升了训练稳定性和图像质量。

-

降低模型失效风险

通过优化引导机制和训练策略,Flux-dev 2 Pro 在微调过程中几乎不会出现模型失效的情况,生成的图像质量更加稳定。 -

减少计算成本

Flux-dev 2 Pro 的引导机制在训练阶段已融入模型,无需额外的计算资源,降低了训练成本和时间消耗。 -

改进蒸馏技术

Flux-dev 2 Pro 进一步优化了蒸馏过程,确保引导机制的信息在蒸馏过程中不被丢失,提升了模型在微调和推理阶段的性能。 -

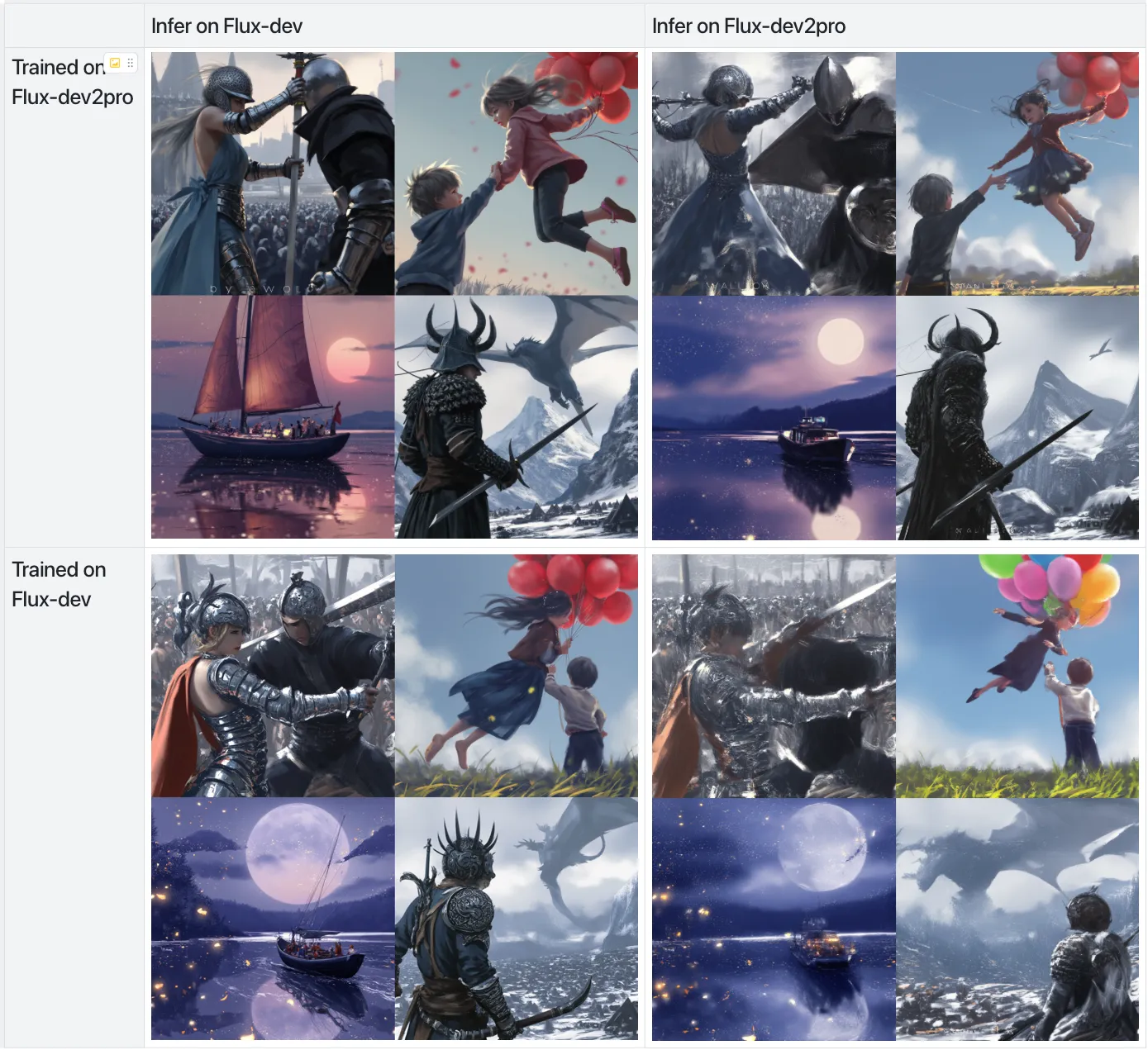

效果提升

- 图像质量:生成的图像细节更丰富,色彩更自然,整体质量显著提升。

- 稳定性:在多种场景下,模型表现更加稳定,不易出现失效或质量下降的情况。

- 适应性:Flux-dev 2 Pro 能够更好地适应不同任务和数据集,生成更符合预期的图像。

第三事:保持学习+懂点代码+巩固基础

第三事,其实是题外话哈,前不久黄教主在越南的时候接受采访,说了以下几句话:

黄仁勋的观点颇具洞见:

在 AI 时代,生产力工具的革新已悄然重塑社会分工的格局,这一趋势正逐渐被更多人感知。然而,无论技术如何演进,人类的基础知识与思维始终是支撑一切的基石。我们的核心任务,并非被工具所取代,而是如何驾驭并引导 AI,使其成为我们实现目标的得力助手。

正如建筑师需要理解力学与美学,才能设计出宏伟的建筑,我们也需要深刻理解 AI 的能力与局限,才能在其基础上构建更高效、更智能的未来。

更多 AI 辅助设计和设计灵感趋势,请关注公众号(设计小站):sjxz 00。