5分钟阅读

写文、配图一气呵成?

前言

emmm~之前一直写AI如何辅助设计的,今天我们换个话题,了解一下如何从写文、出图、润色,一条龙! 适合场景?

- 当然是自媒体,如果抽卡抽多了,有个文章框架后,人工润色编辑,就可以发文啦

- 用于设计前期的研究。我们知道,设计前期是需要讲故事的,利用这个工作流,可以一键出完剧本,然后加以调整即可。

- 用于剧本?例如故事探索之类的。 当然,以上场景是我YY出来的,实际也不一定适用,但是,AI串联工作流,这个趋势已然形成,大家还是要关注这个技术方向。

看看效果

下面是使用这个工作流一键输出的图文。

情感散文

图文配合度很高,情绪挺到位了 ,稍微润色就可以出街了 😂

漫画类图文

这个要配合ComfyUI工作流,无论文本,还是漫画上面的字体,都是由llm统一输出和控制的。

心灵鸡汤文仿写

这种文章是直接爬取网络的文章进行仿写的,把图片替换为ComfyUI生成的图。

实现原理

今天我先讲个实现原理,后面找时间再展开说说。 用到的平台:

- ComfyUI API后端。我用flask实现的API后端,用于建立Dify和ComfyUI的连接。

- Dify,当然也可以用Coze,但是开源免费的,我还是推荐Dify

- ComfyUI

ComfyUI API后端

项目介绍

此项目我已经开源:https://github.com/leoleelxh/comfyui-api。

熟悉Dify的朋友可能会问,为什么不直接用Dify的ComfyUI工具?答案就是,该工具没有实现我想要的效果,所以就干脆自己实现了一个后端。

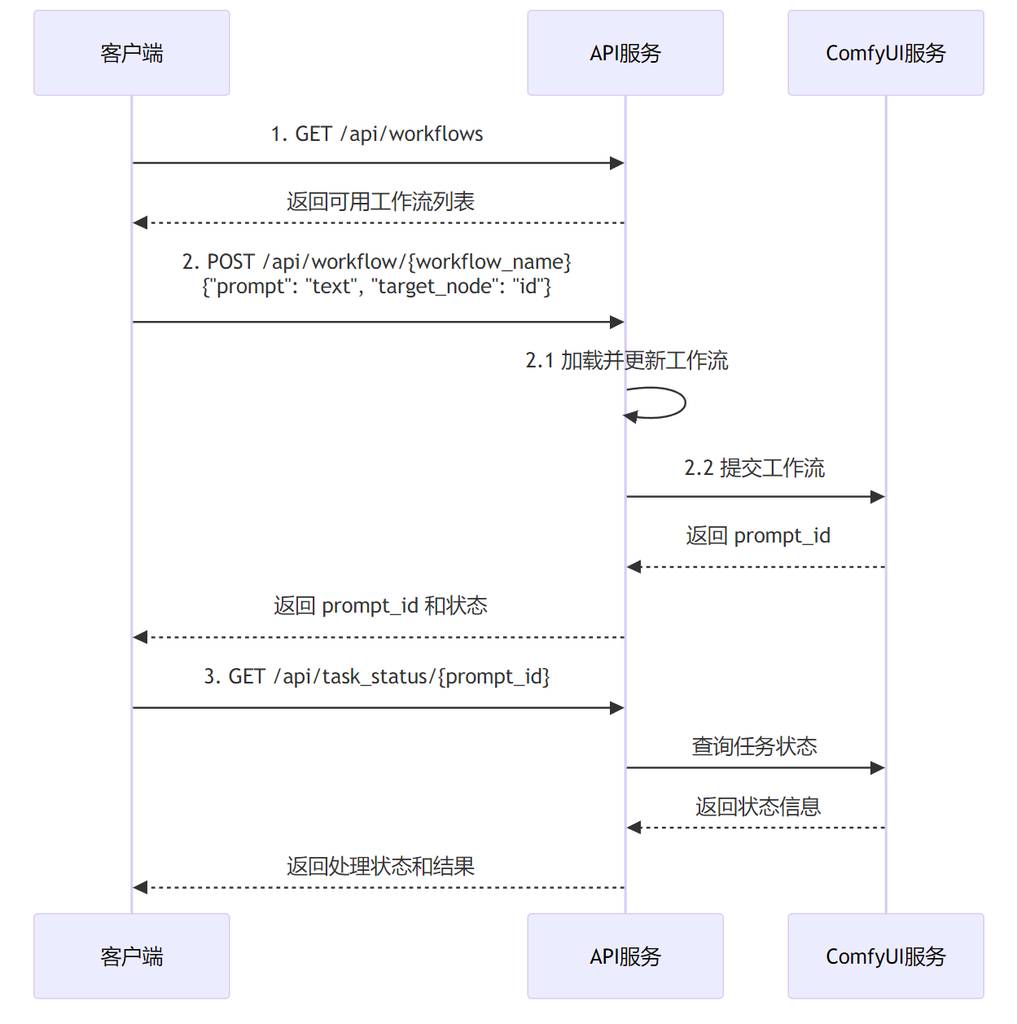

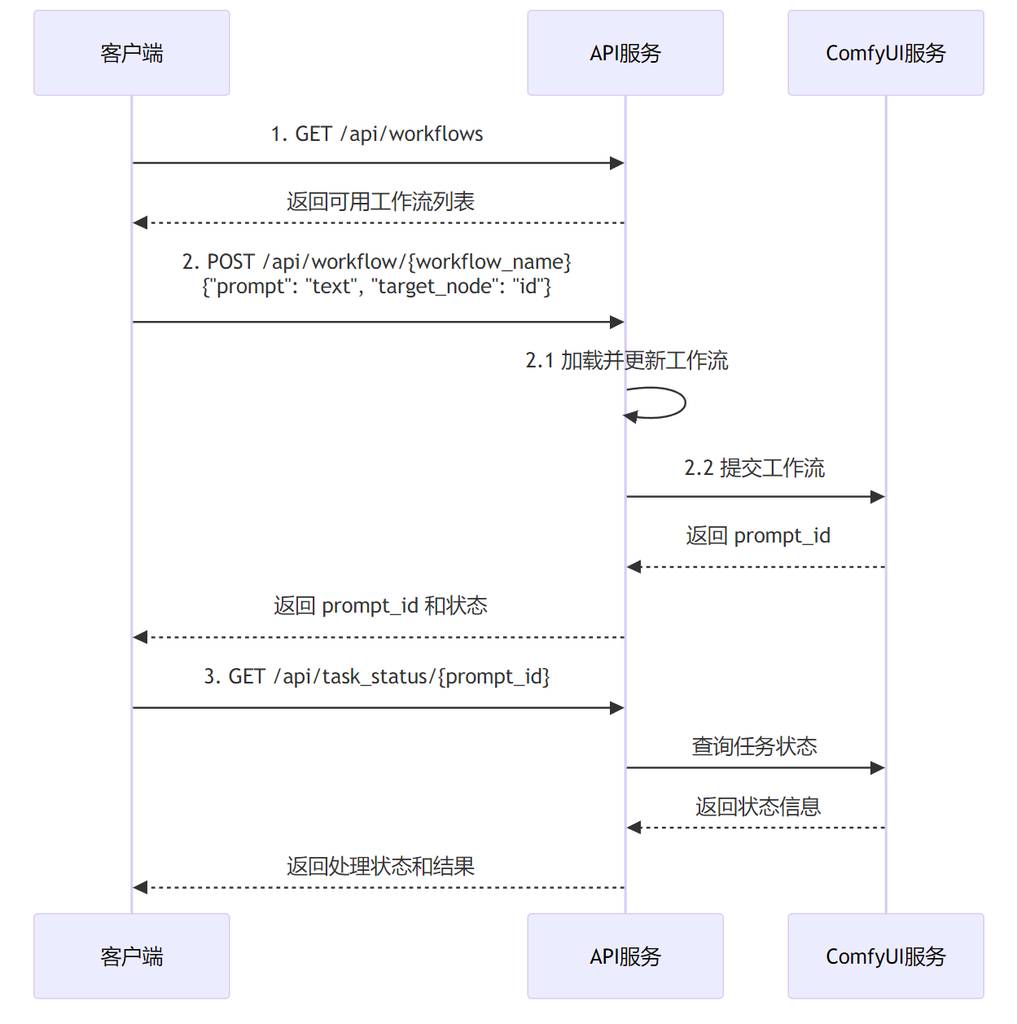

回到API本身,该调用方法流程如下,详细可看项目介绍。

在这个API中,可以很灵活地调用和传入参数。例如:

{

"node_id1": {

"inputs": {

"text": "your text for node 1"

}

},

"node_id2": {

"inputs": {

"text": "your text for node 2"

}

}

}

这样就可以指定ComfyUI的节点ID,传入指定参数。

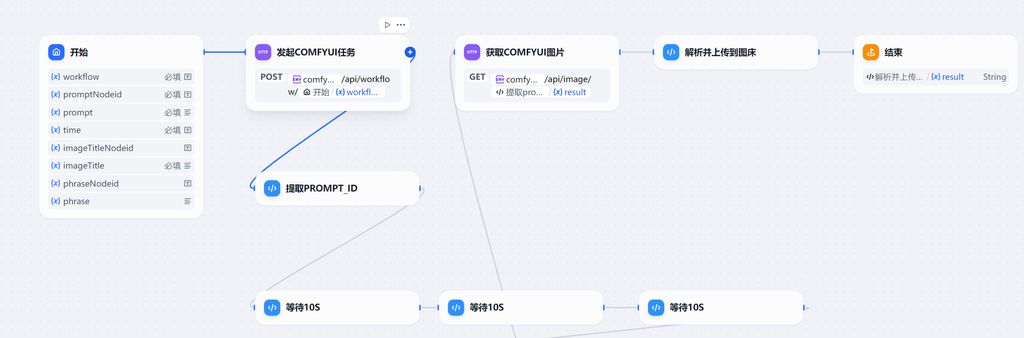

如何调用?

主要是用到Dify的http请求节点。

这里我调用后,还有一个上传图床的操作,主要是方便图文输出的时候调用方便。

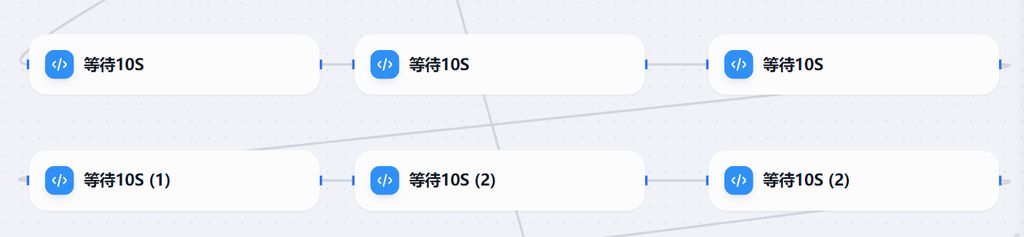

这里有个难点,如果有开发大佬看到也帮忙看看:http请求存在异步问题,所以发起任务后,直接请求image是不行的,我这里做了个骚操作🥱,串联了一堆代码执行节点,用于设置等待时间。

设定好这套工作流后,可以保存为工具,稍后用到完整的一键图文工作流中。

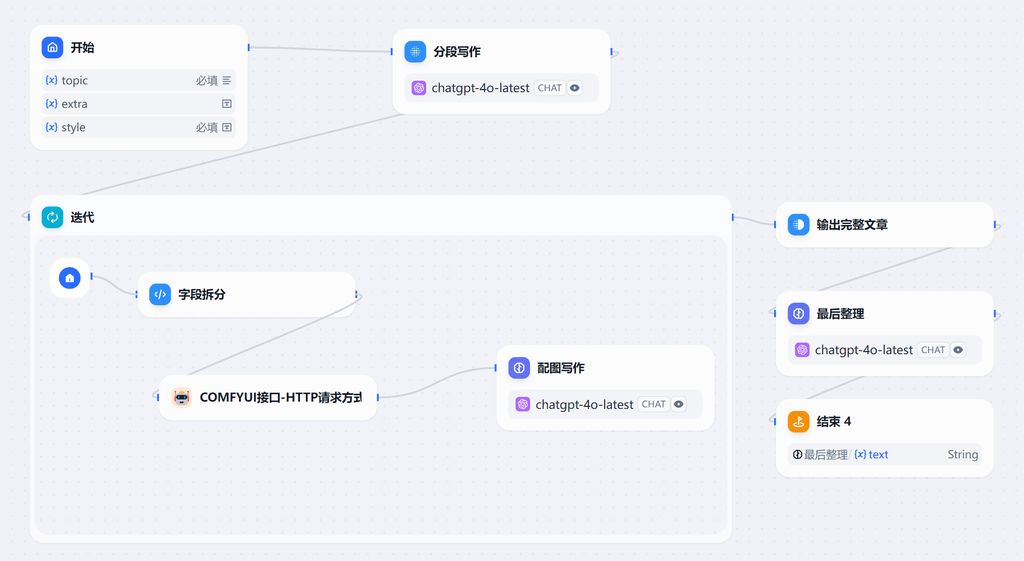

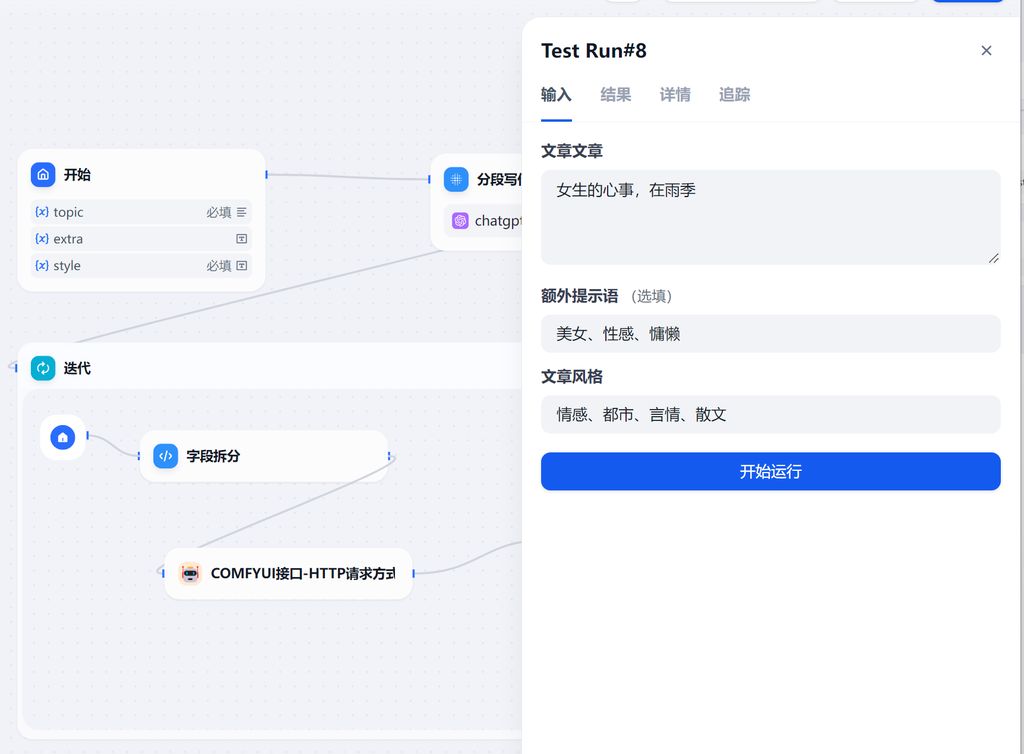

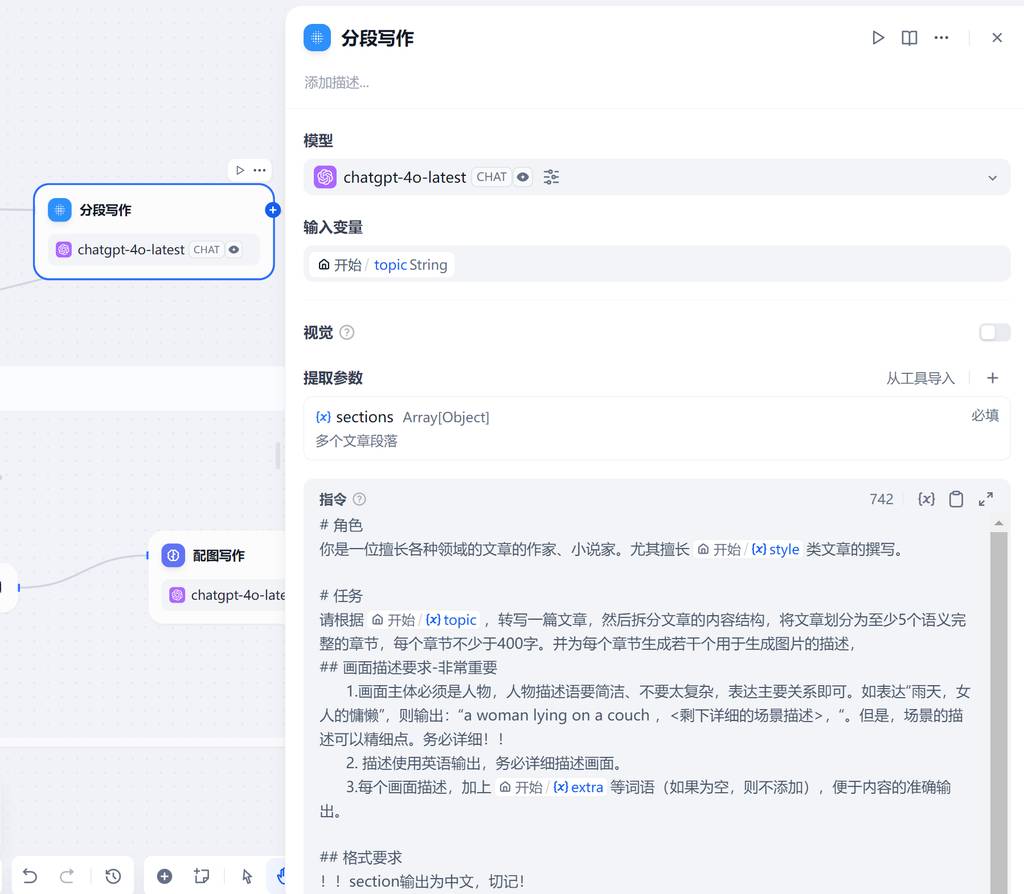

Dify中完整工作流

其实原理也很简单,步骤如下:

- 指定主题。

- llm撰写文章,并按照指定json格式输出。需要生成文章段落和相对应的ComfyUI提示语

- 迭代解析分段,每段提取提示语传入ComfyUI进行出图。有多少个段落就迭代多少次。

- 最后llm根据迭代的整理输出,润色文章。

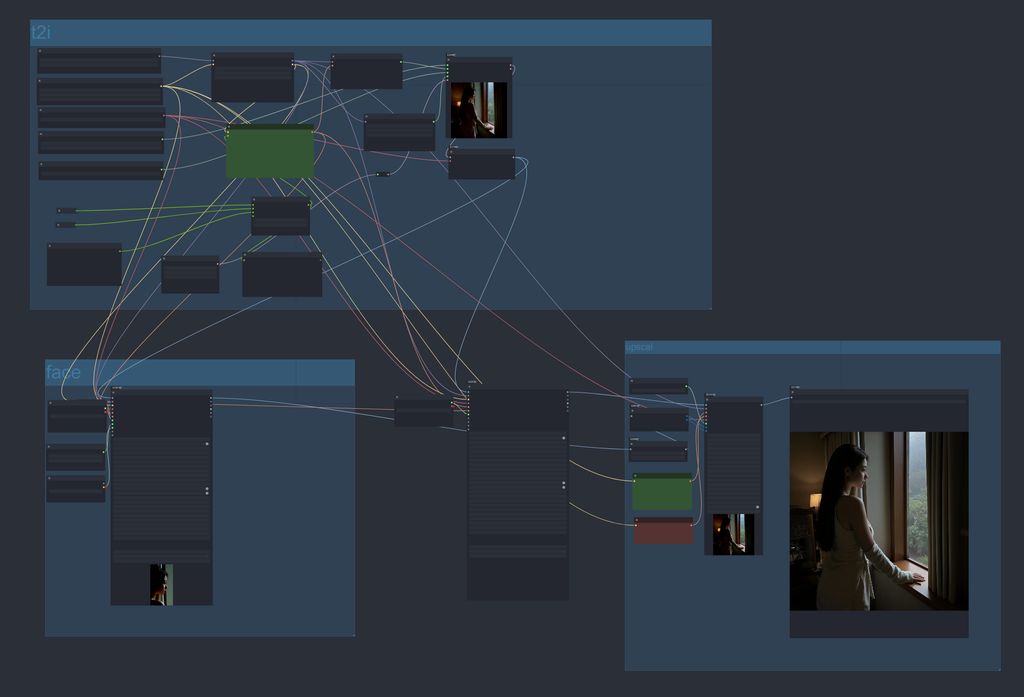

ComfyUI工作流

根据实际需求,制作相应的ComfyUI工作流。并保存为API供后端调用。

例如,这个情绪版生成工作流。使用FLUX底模进行生成,通过脸部、手部优化,最后进行放大方式,实现精美的美女情绪片😂。

写在最后

今天先开个头,因为涉及到环节还是挺多,也挺复杂的,后面我还会分享一些文章。

更多 AI 辅助设计和设计灵感趋势,请关注公众号(设计小站):sjxz00。