5分钟阅读

喂饭级!WAN21这么猛!Stage Attention和Sigma Split加速必须安排上!

前言

相信大家都被 WAN 2.1 刷屏过了,作为一个开源的视频生成模型,实力非凡!

不得不说,从 QWEN 到 WAN 2.1,阿里的实力是刚刚的!杠把子。👍。

过多的赞叹就不再表达了,我们今天关注一下,普通机器如何使用这个优秀的视频生成模型。 再细一点,主要是看看如何在 ComfyUI 中使用其 GGUF 版本和进行Stage Attention 加速以及Sigma Split 采样优化。 这两个加速技术结合 GGUF 模型,可以让 8 G 显存的机器都能快速跑起来。 但是!这两个东西确实难装!为此,我为大家踩了一些坑,找到一种比较安全有效的方法。

[!NOTE] 注意了哈,本文只针对Stage Attention 加速以及Sigma Split 采样优化这个两个插件和依赖进行安装教学,其他的基础准备,以及 ComfyUI 的其他安装,各位看官自行搜索哈~

插件安装

⚠️ 注意:建议大家使用新的 ComfyUI 进行以下操作,因为很容易搞坏原来的环境😂。

条件:

本文预设的条件是大家都具备了以下条件,没有具备的,大家检查一下。

- CUDA 版本>= 12.4

- Pytorch>=2.6.0

- ComfyUI 版本最好更新到最新

- VisualStudio 及 Windows 开发组件

- KJnode 和ComfyUI-WanVideoWrapper 更新到最新版本

- 科学上网环境

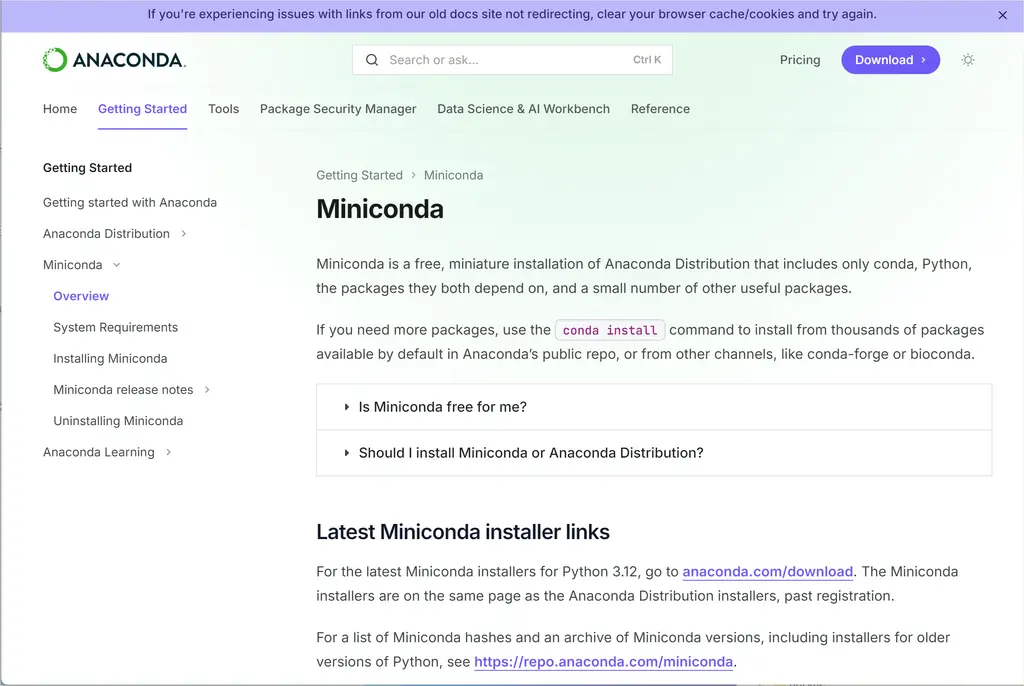

- Conda 环境。使用 miniconda,具体安装查看官网。

https://www.anaconda.com/docs/getting-started/miniconda/main

VisualStudio 及 Windows 开发组件:

Conda 官方:

安装 ComfyUI

具体过程,我就大致列一下步骤了,不是本次的重点。需要提一下,建议使用 conda 来安装。这样可以隔离环境,坏了就进行更换即可。

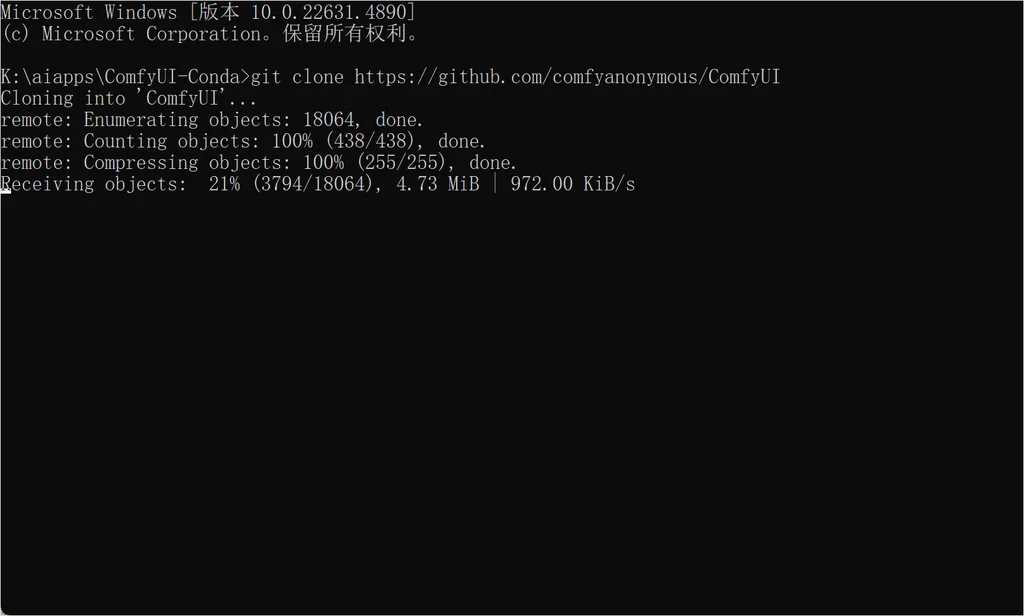

拉取 ComfyUI 项目:

git clone https://github.com/comfyanonymous/ComfyUI

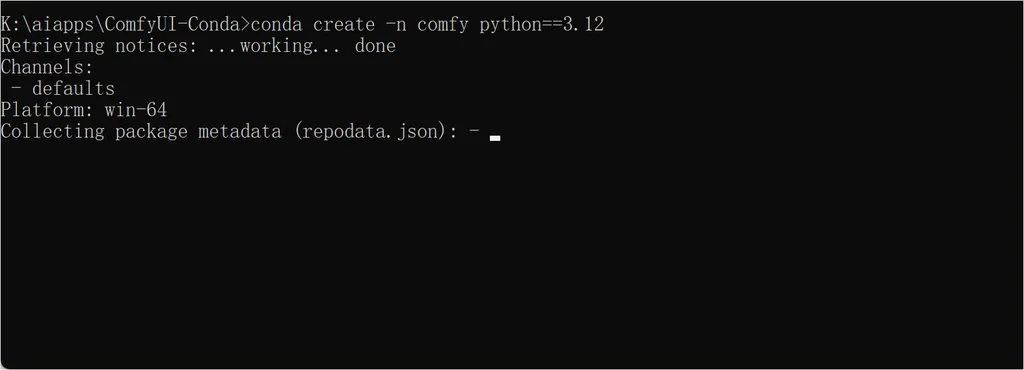

创建 conda 环境

注意环境选择 python 3.12 版本,这样出错概率少点。

conda create -n comfy python==3.12

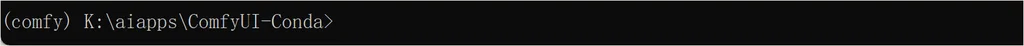

进入 comfy 的 conda 环境

conda activate comfy

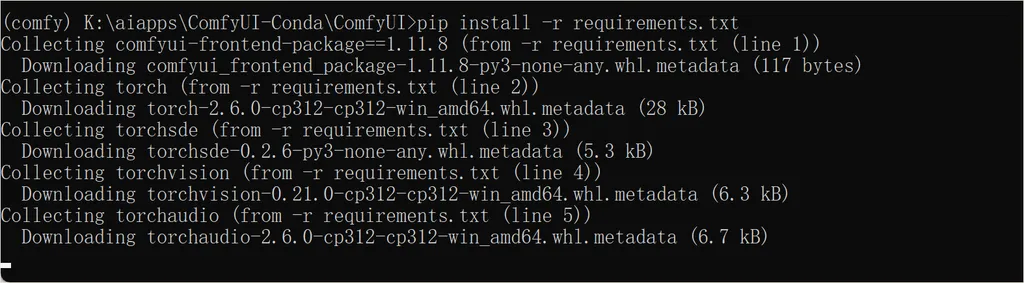

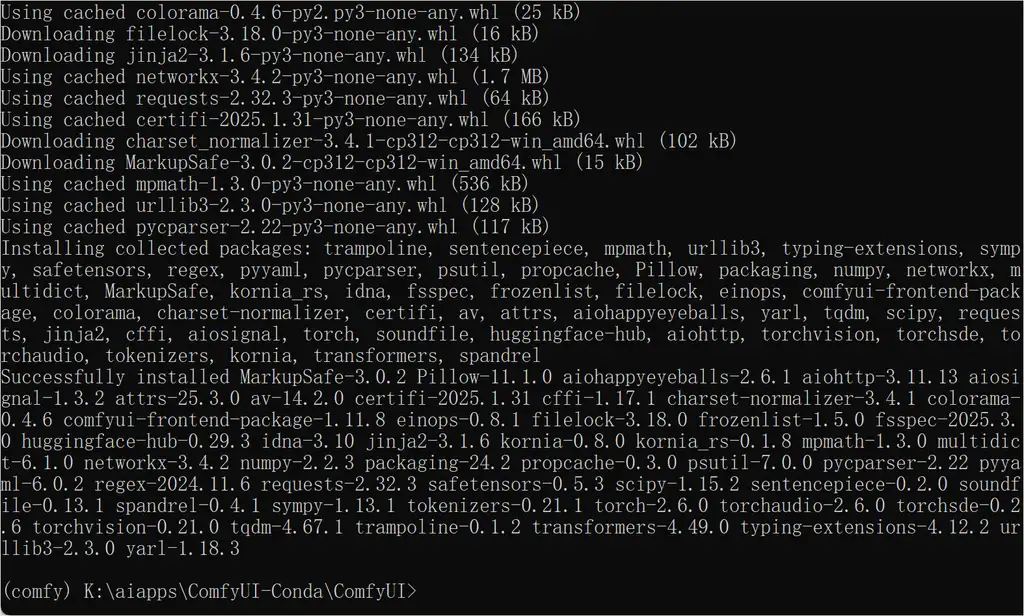

安装 ComfyUI 依赖

cd ComfyUI

pip install -r requirements.txt

耐心等待安装完成。

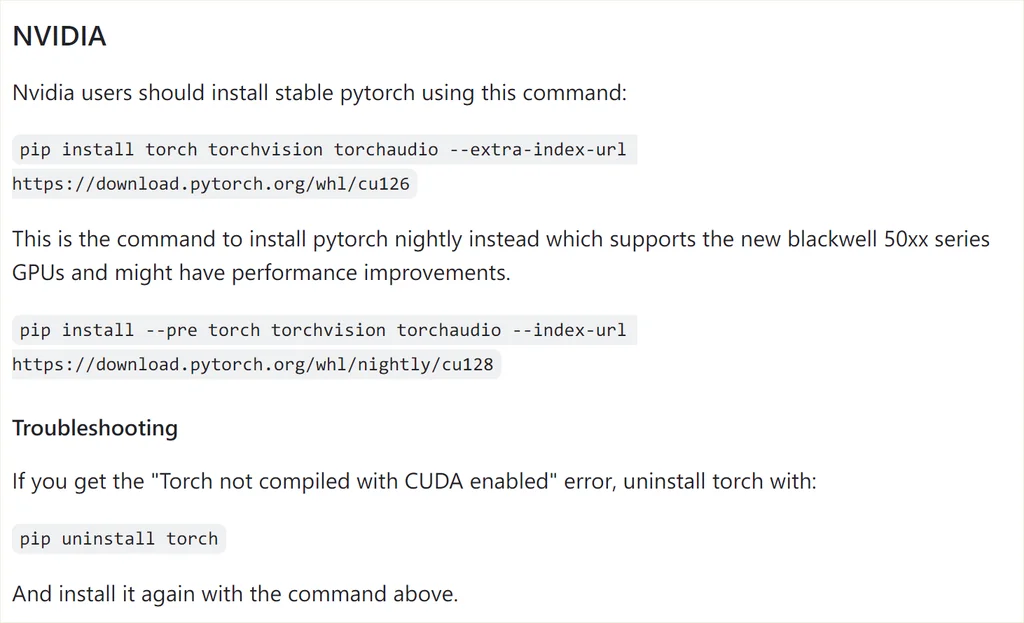

敲黑板:手动安装依赖情况下,如果是 nv 的 gpu,默认不会安装 cuda 版本的 torch 的,需要执行以下命令。

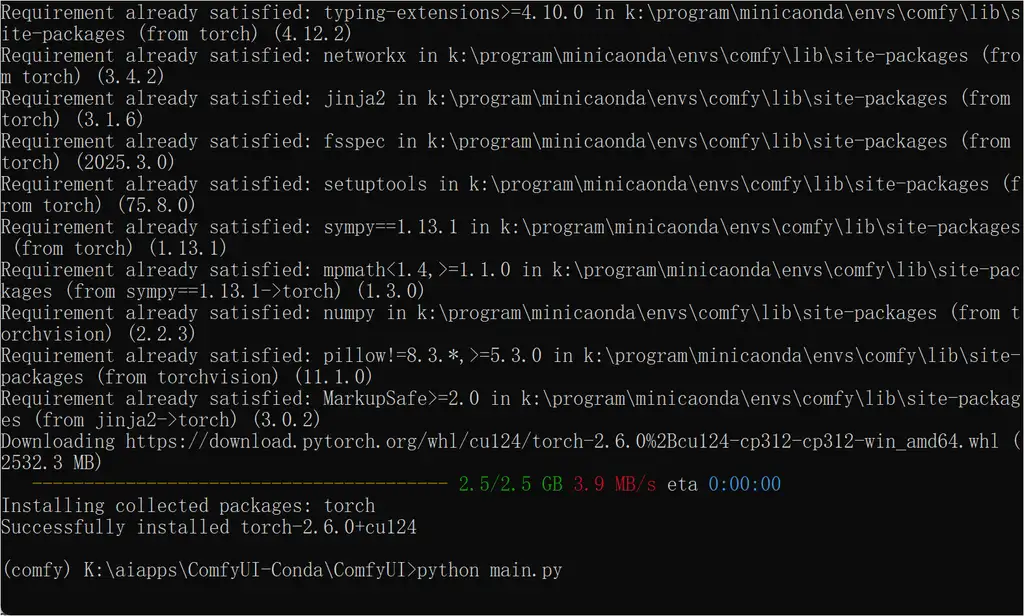

注意 cuda 版本,我是 12.4,所以是 cuda124:

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu124

官方的 github 的 readme 说的很清楚的:

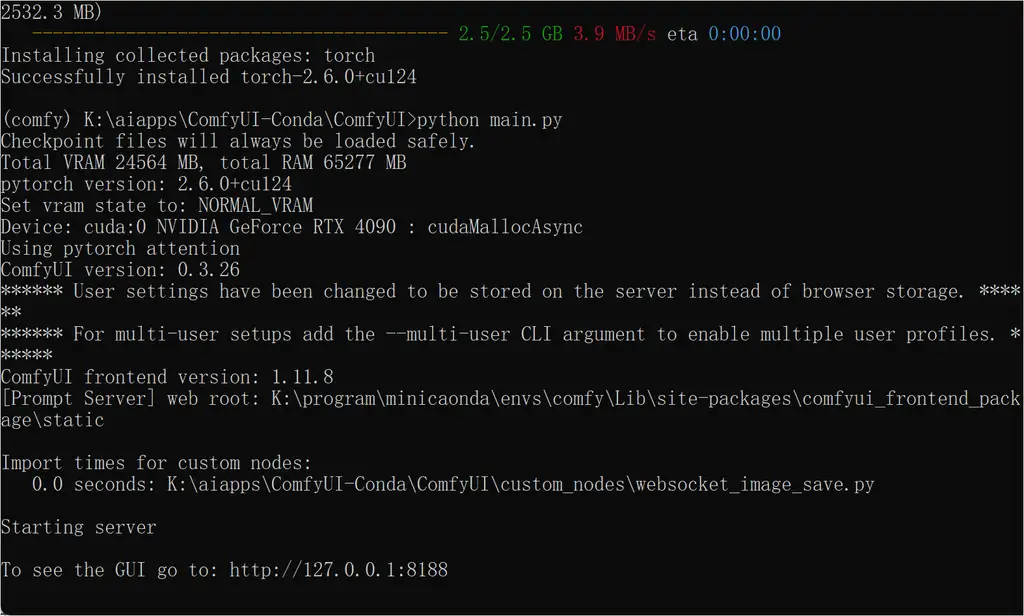

启动 ComfyUI,确保无错后进入下一个环节。

python main.py

这里教大家一个技巧:对于多个环境,如何使用一套模型呢?

建立符号连接!参考以下格式:

mklink /D "K:\aiapps\ComfyUI-Conda\ComfyUI\models" "J:\ComfyUI-aki-v1.1\models"

这样在新的 ComfyUI 目录下,就生成了一个 models 文件夹,其实是在原来的 ComfyUI 目录下的,这样可以节省空间。

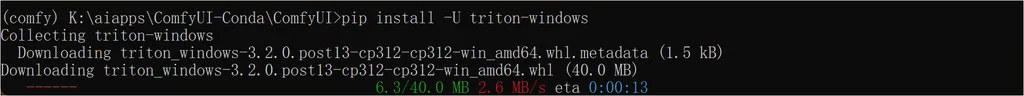

安装 triton

pip install -U triton-windows

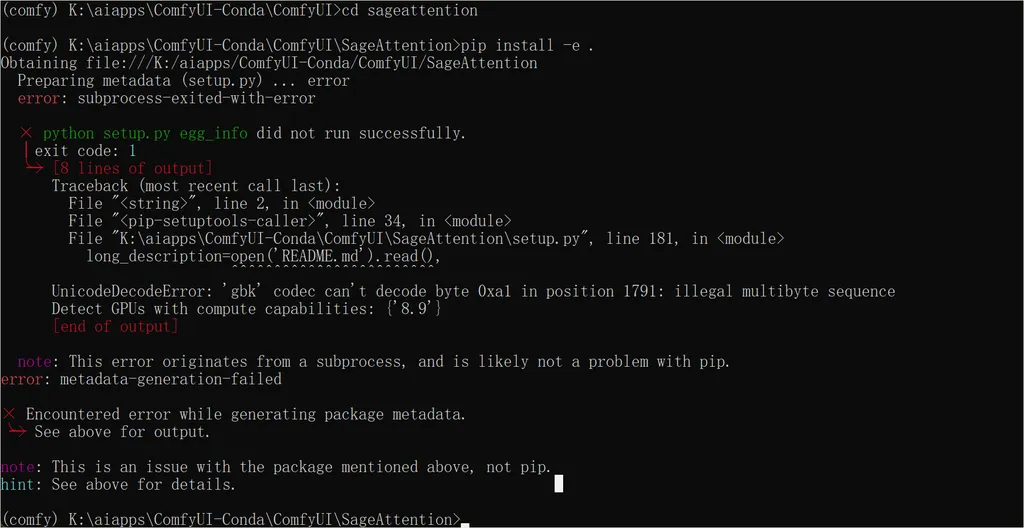

安装 SageAttention

源码安装

git clone https://github.com/thu-ml/SageAttention.git

cd sageattention

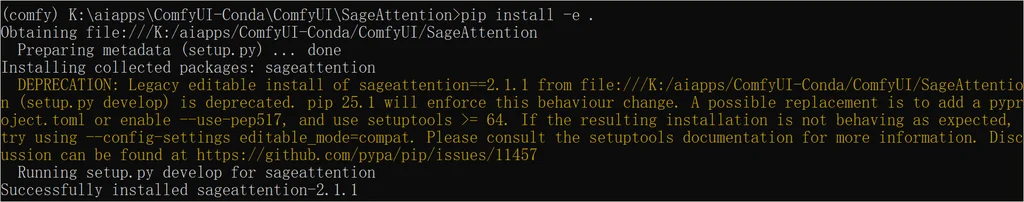

python setup.py install # or pip install -e .

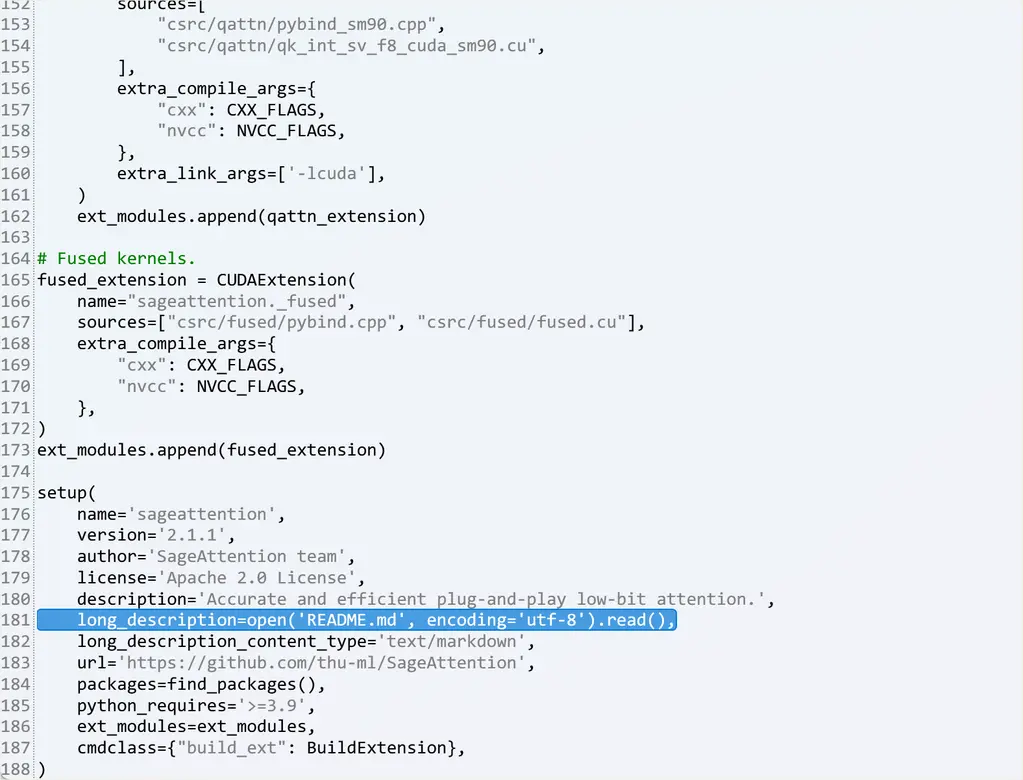

如果报编码错误,

修改成下面:

耐心等待安装。

安装插件

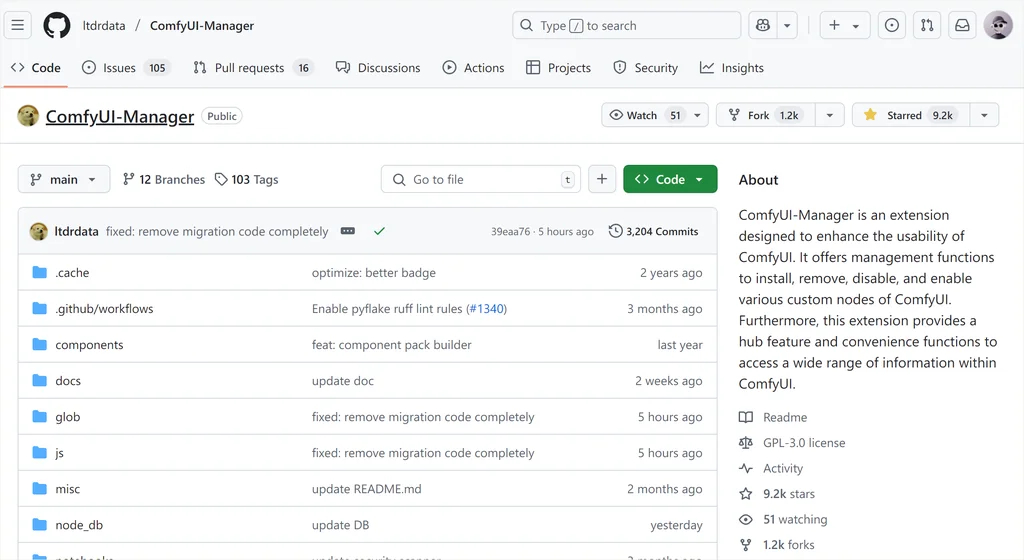

安装 manger 插件

为了方便插件安装,建议先 manger 插件 https://github.com/ltdrdata/ComfyUI-Manager。

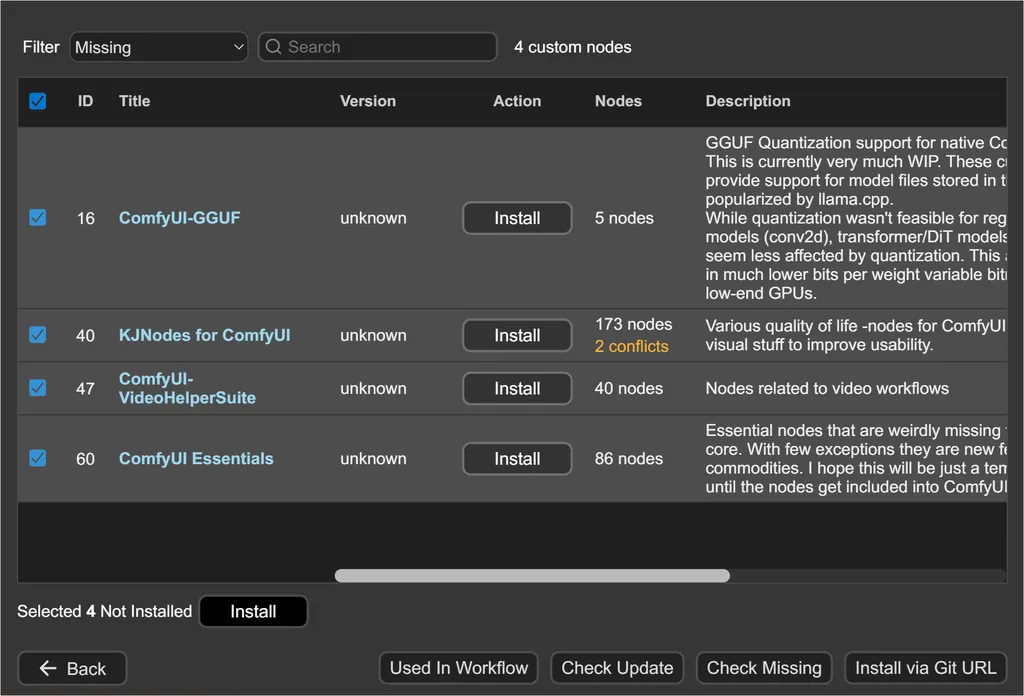

安装 wan 相关插件

插件列表如图:

全部安装就行。

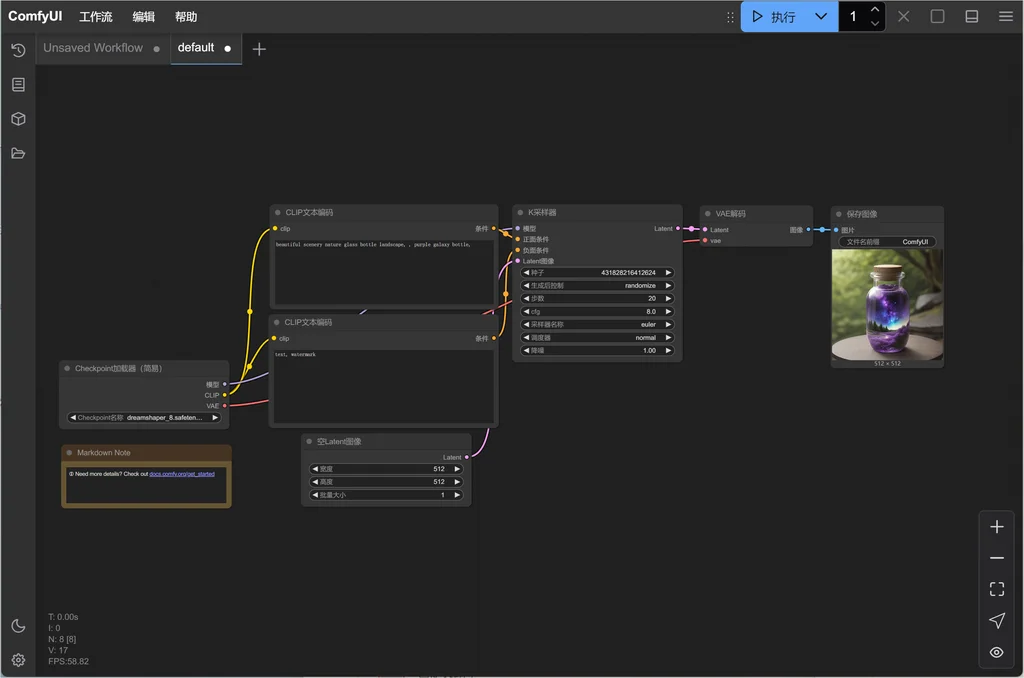

运行测试

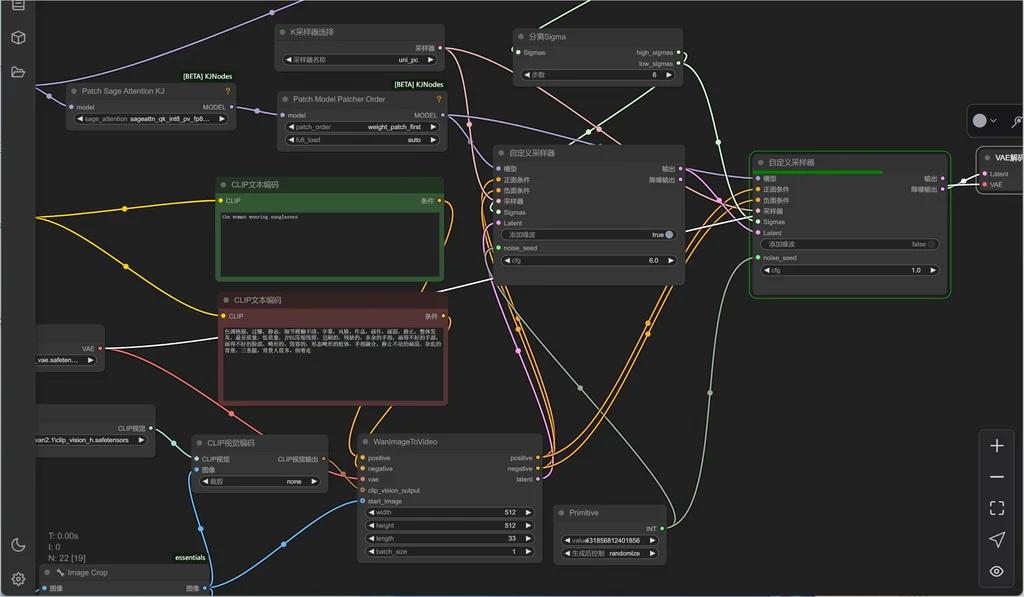

运行工作流

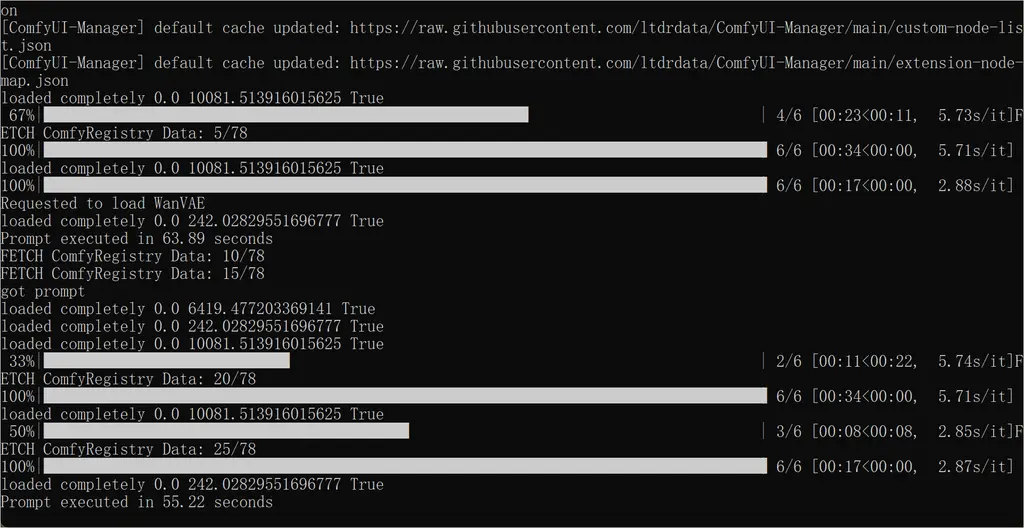

看到这个信息,正面就可以加速了!

512 分辨率,2 秒视频,用时 55 秒。

人物动作生动自然,物理正确!

好了,今天分享就到这里,大家改进部署起来,用起来吧!

想获取更多 AI 辅助设计和设计灵感趋势? 欢迎关注我的公众号(设计小站):sjxz 00。