5分钟阅读

最近值得关注的几项AI技术

同学们,真的跟不上、学不完啊!AI技术日新月异,各种新产品、新技术不断涌现,哪怕不关注一天,就如同隔了一个时代,毫不夸张的说。 最近各个大厂、前沿科技公司,纷纷发布了在AI领域的新技术和方法,设计小站也带大家整理以以下。

信息要点

有以下几点信息:

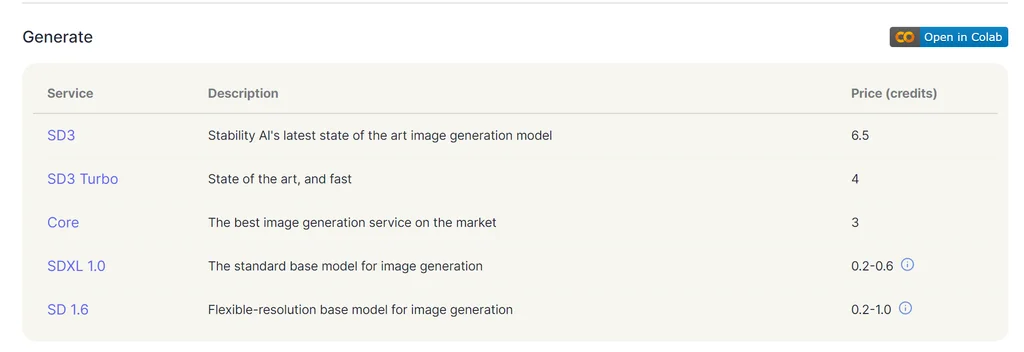

- 🖼️ SD3发布。但仅限于API调用,还有点小贵,虽然比MJ便宜了点

- 🗣️ 阿里EMO正式发布在线体验版本。这估计是不会开源的节奏啊

- 👾 HiDiffusion代码发布。无需训练,一行代码提升SD的生产图像尺寸和速度。论速度还得是字节啊。

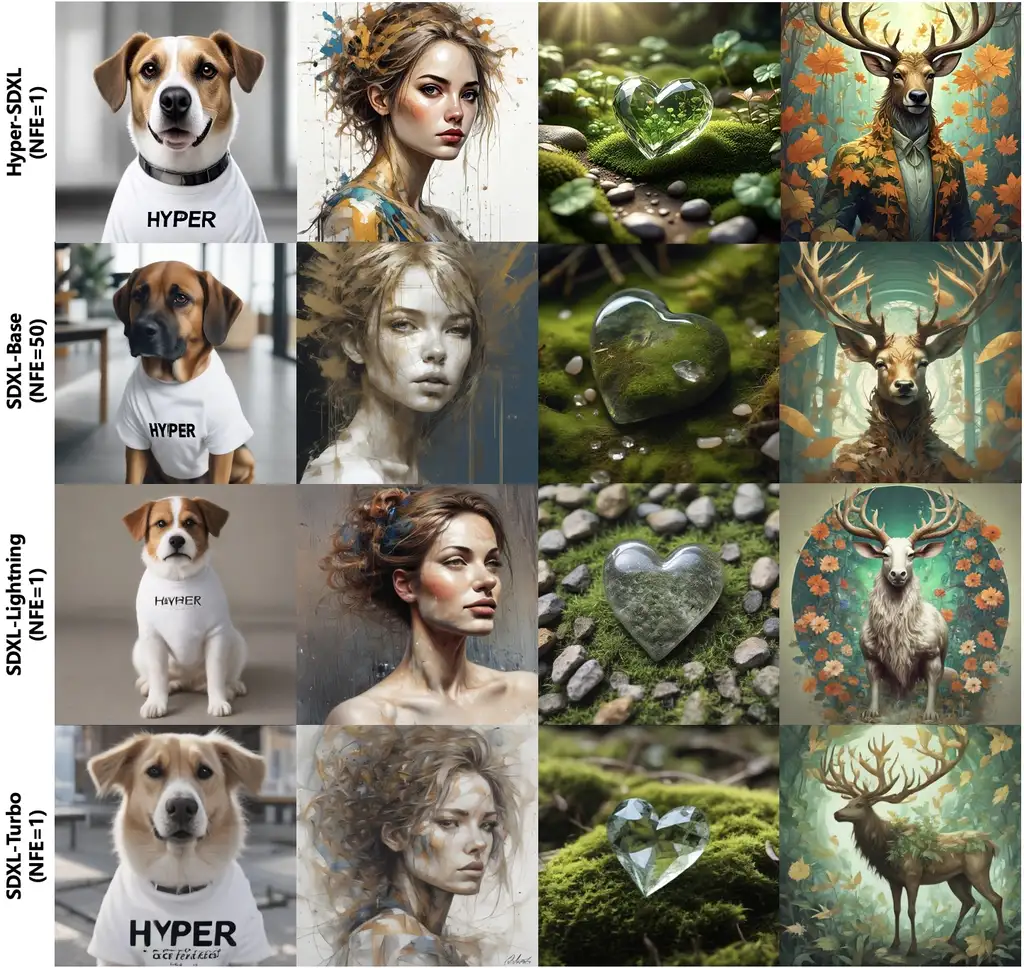

- 💅 Hyper-SD。还是字节,还是在提升SD速度方面的研究,实时绘画更接近可用了。 接下来一个个看

SD3发布

关于SD3,网上已经有太多信息和介绍了,所以设计小站近期没有趁热度发布相关文章,倒是之前有发布过一期:# 【AI辅助设计】很能打!SD3的最新动向。 但这期因为是大杂烩,所以不得不提一下,毕竟是开源界赛博佛祖的新闻。 正如大家期待的,SD3在图片生成质量、提示语的理解、以及文字生成方面,得益于Sora同款的DIT技术,都得到了质的飞跃。

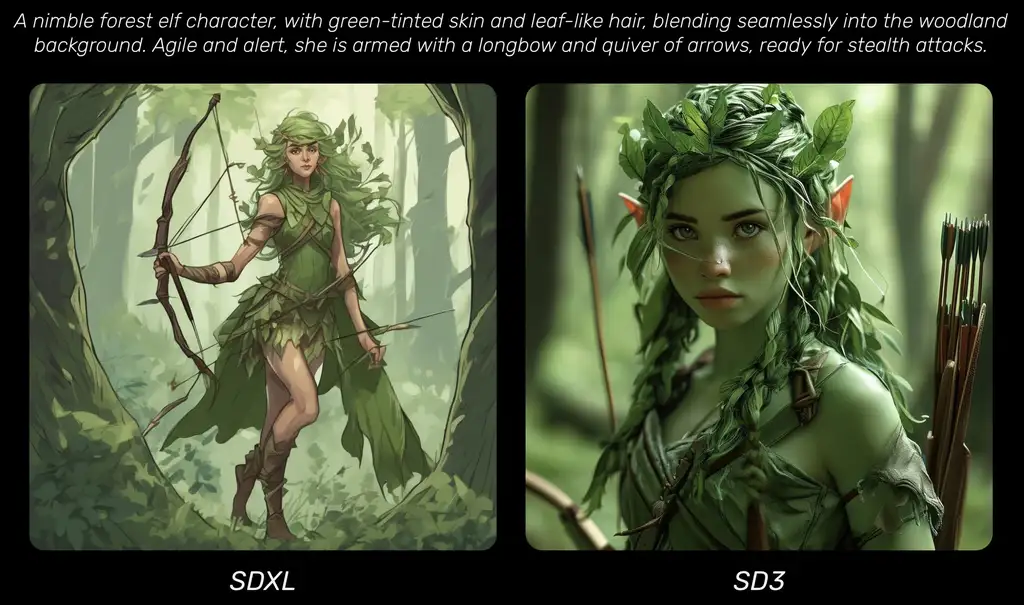

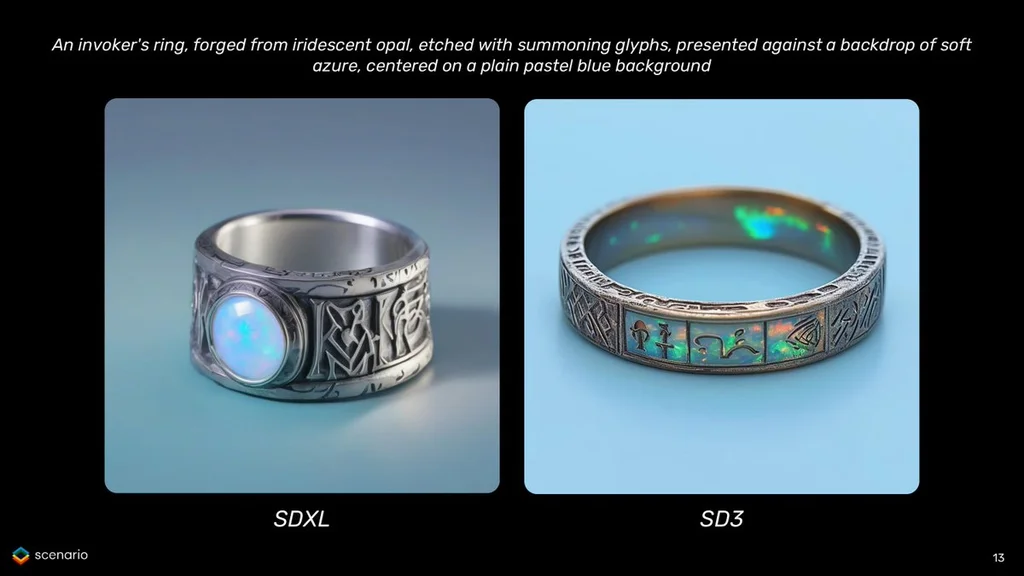

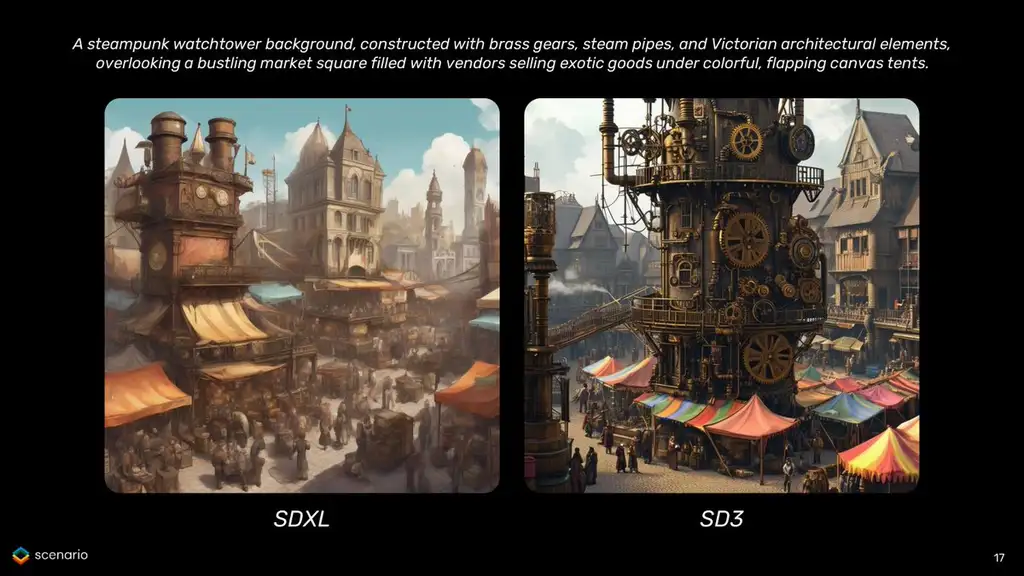

SD3的最终效果

关于SD3的效果,网上很多博主已经po出了高质量的图,效果拉满了。

@Emm 使用同一个提示词,跟SDXL和SD3的出图对比:

如何使用?

目前SD3只支持API的方式调用,是需要付费的。API地址:https://platform.stability.ai/

阿里EMO

相信之前被EMO刷屏的朋友们都很期待,这是之前放出的视频:

—视频号—

之所以EMO的效果如此自然,是因为他们在算法设计上有一些创新。他们摒弃了针对人脸的显式建模,而是采用了一些相对较弱的控制条件,让diffusion模型自主学习表情和动作,从而保留了模型强大的生成能力。同时,他们还加入了face locator和speed layers,精细控制人脸区域和动作频率,进一步提升了生成效果。

在表情和口型的一致性方面,EMO的模型通过大量训练数据,找到了音频特征与图像像素之间的对应关系,让人物表情和口型能够与音频完美同步。更重要的是,模型还学会了将语气特征和情绪色彩传达到人物的微表情中,使整体效果更加自然生动。

体验的申请地址,我没有验证过,打开还是404错误,所以就不贴上了,大家还是继续期待吧。但是官方也确实已经开放了在线体验了。

HiDiffusion

不得不说,字节在“快”,这上面,是独步天下。之前我们介绍过SDXL-Lightning模型# 【AI辅助设计】就在刚刚!字节发布SDXL-lightning!没有最快只有更快!,速度飞快,这次又推出了HiDiffusion。

HiDiffusion简介

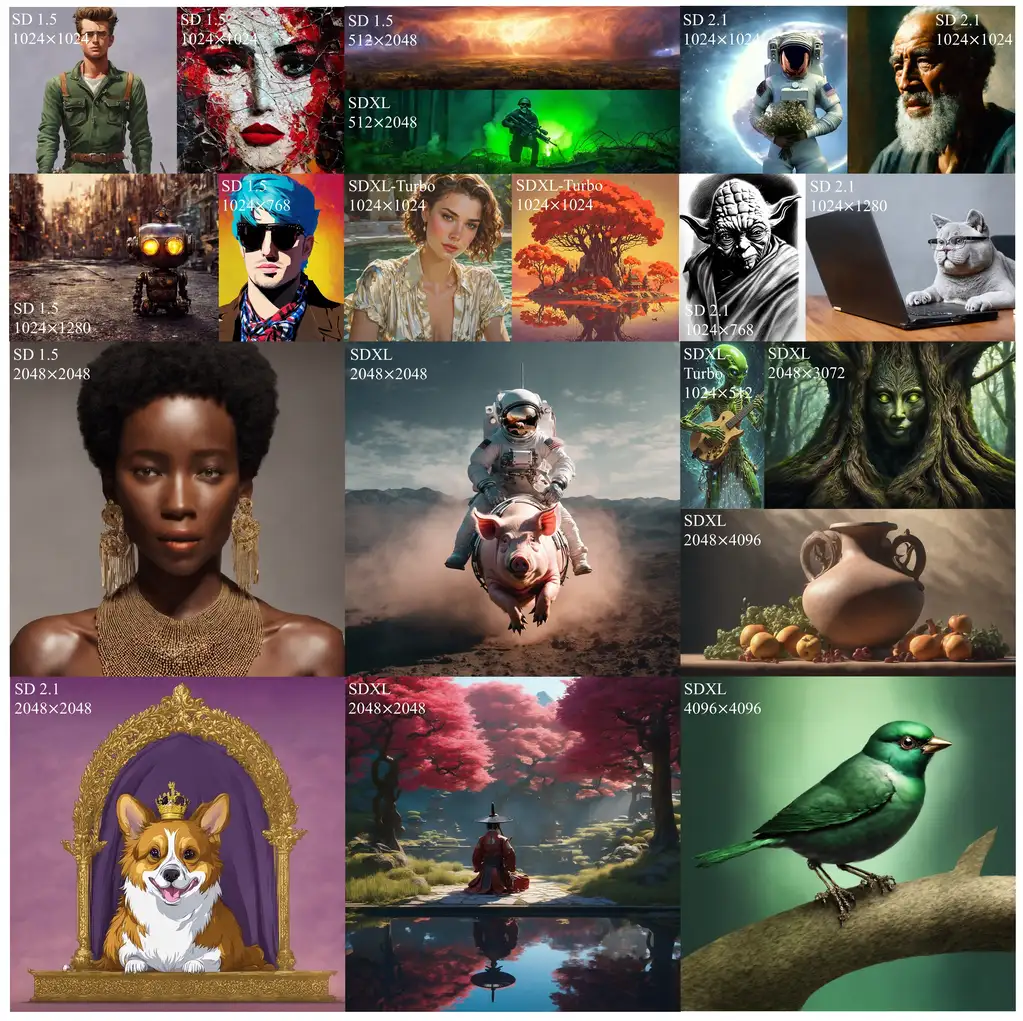

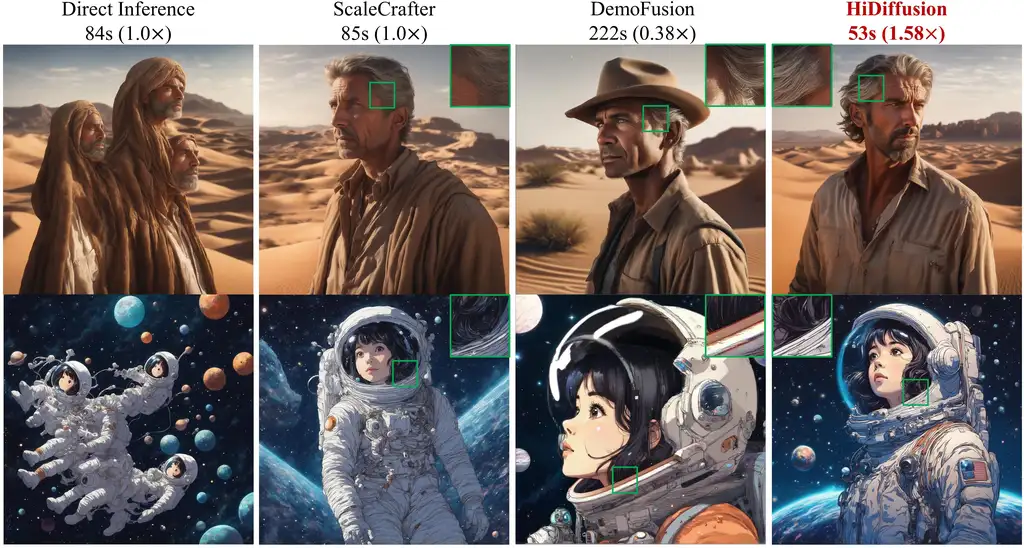

无需经过繁琐的训练过程,只需一行代码即可显著提升SD图像生成的清晰度和速度。 HiDiffusion框架支持将图像生成的分辨率提高至4096×4096,并将生成速度提升1.5至6倍。同时兼容所有SD模型及其下游应用,如Playground。

官方的介绍:

在尝试使用已经训练好的扩散模型生成更高分辨率图像时,我们常常会遇到图像中对象重复的问题,同时生成时间也会大幅增加。 通过研究,我们发现这种对象重复现象是由于U-Net模型深层特征的重复所致。 此外,我们还发现U-Net顶层自注意力机制的冗余操作导致了生成时间的增加。 为了解决这些问题,我们提出了HiDiffusion框架,一种无需额外调整的高分辨率生成框架。

HiDiffusion框架包含了感知分辨率U-Net(RAU-Net),能够动态调整特征图尺寸,有效避免了对象重复的问题。 此外,我们还引入了修改版移位窗多头自注意力(MSW-MSA),一种优化后的窗口注意力机制,大幅减少了计算量。

通过将HiDiffusion应用于各种预训练的扩散模型中,我们成功将图像生成的分辨率提高至4096×4096,并将生成速度提升1.5至6倍。 经过广泛的实验验证,我们的方法不仅解决了对象重复和高计算负荷的问题,同时在生成高分辨率图像的任务上取得了前所未有的效果。

Hyper-SD

字节公司最新推出了一款全新的加速框架——Hyper-SD,并且还直接提供了ComfyUI工作流,为用户带来更加便捷的体验!

这个框架引入了轨迹分段一致蒸馏和人类反馈学习的技术,同时还集成了分数蒸馏的方法。 Hyper-SD在1-8低步数推理中表现出了最佳的性能,适用于SDXL和SD1.5。

- 项目:https://hyper-sd.github.io

- 模型:https://huggingface.co/ByteDance/Hyper-SD…

- 工作流:https://huggingface.co/ByteDance/Hyper-SD/blob/main/comfyui/Hyper-SDXL-Nsteps-lora-workflow.json…

- 在线Demo:https://huggingface.co/spaces/ByteDance/Hyper-SDXL-1Step-T2I

还没测试,估计这个方法会比SDXL-lightning速度会更快,实时绘画可以说更进一步了。

好了,关于的分享介绍就到这里,有什么疑问或者问题,可以留言交流哦~

关注我公众号(设计小站):sjxz00,获取更多AI辅助设计和设计灵感趋势。